想象一下,你让 AI 帮忙订会议室:

- 旧版 AI:“明天我有空”

- 新版 AI:“老张!明天我全天在客户那,周四上午咱们技术部小会议室空着,要帮你留 9 点的档期吗?顺便提醒上次你说要带新来的实习生一起”

这种质的飞跃,正是 Shopify 老板 Tobi Lutke 提出的”语境工程”在发挥作用——它让 AI 不再是个只会答选择题的考生,而是变成了懂得察言观色的职场老手。

1.从提示工程到语境工程的范式跃迁

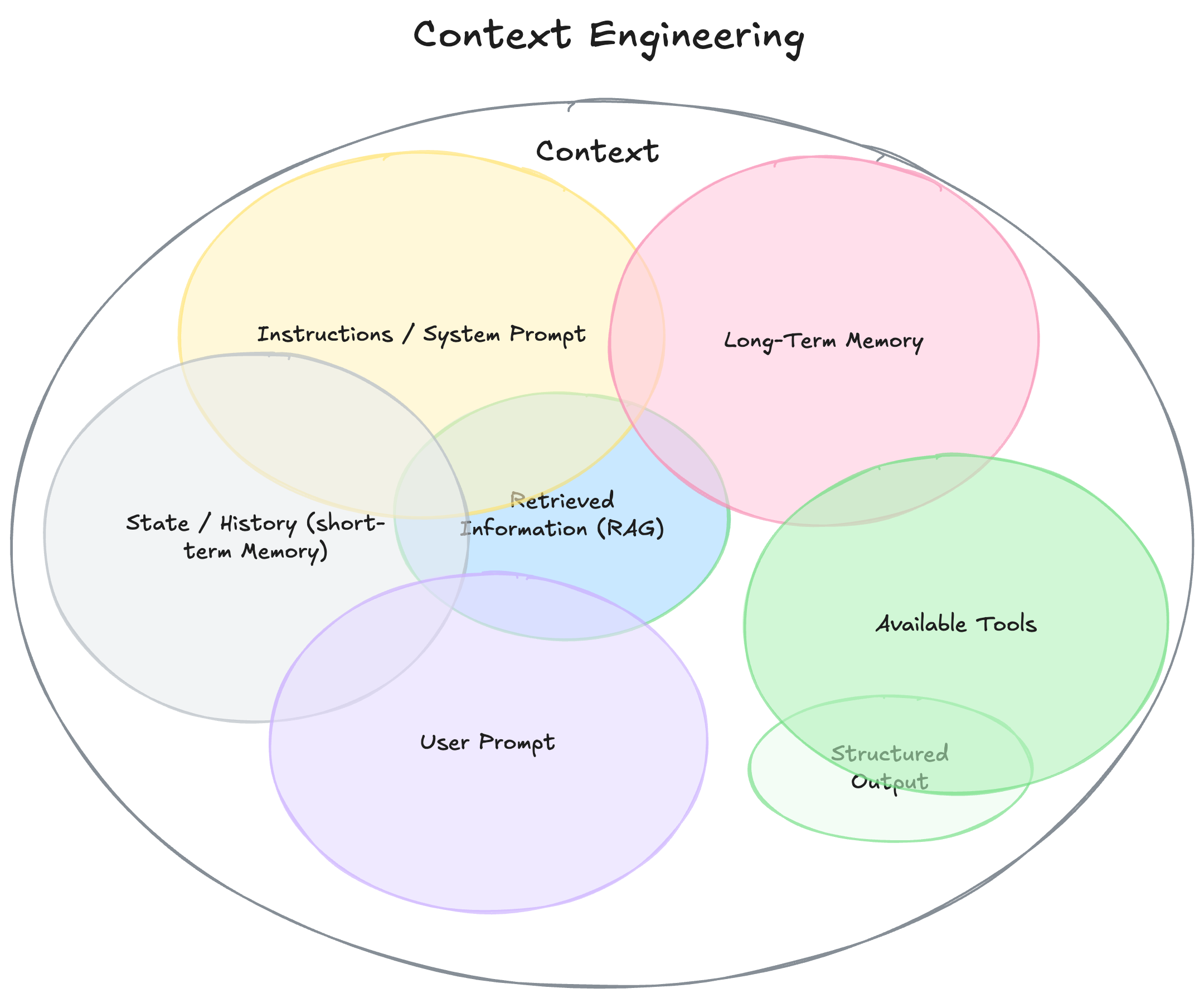

当 Shopify 首席执行官 Tobi Lütke 首次提出语境工程概念时,他将这一新兴领域精辟地定义为”为任务提供所有必要语境,使大语言模型能够合理解决问题的艺术”。这个定义准确地捕捉到了 AI 技术发展的最新趋势。在传统的提示工程方法中,工程师们主要专注于优化单次交互中的指令设计;而现代语境工程则代表着一种更全面的思维转变,它致力于构建一个完整的认知生态系统,这个系统包含多个相互协作的模块化组件。具体来说,一个完善的语境系统需要整合系统指令(定义模型行为的基本准则)、短期记忆(记录当前会话的历史交互)、长期记忆(存储跨会话的用户偏好和知识)、工具接口(提供 API 调用等扩展能力)以及实时检索信息(通过 RAG 技术获取外部知识)等关键要素。

行业数据分析显示,在智能代理的失败案例中,高达 73% 的问题根源在于语境构建缺陷,而非模型本身的能力不足。这种统计结果凸显了语境质量对 AI 系统性能的决定性影响。我们可以通过一个典型的会议安排场景来直观理解这种差异:当处理简单的会议请求时,一个仅具备基础功能的简陋代理往往只会机械地回复”明天我有空”这样程式化的响应;而一个配备了完整日历数据、理解历史沟通风格并能识别联系人关系的魔法级代理,则能够生成高度人性化的响应:“Jim!我查看了日程,明天已经全天排满,不过周四上午还有空档,需要帮您预定这个时段吗?“这种鲜明的对比完美印证了 AI 领域著名的” 80/20 法则”——在实际应用中,80% 的性能提升往往来自于那 20% 关键的语境优化工作。

2.长上下文窗口的双刃剑效应

尽管当前最先进的大模型如 Claude 3 已经支持 200K 的上下文窗口,Gemini 1.5 Pro 更是突破了百万 token 的技术壁垒,但最新研究揭示了一系列令人警惕的现象:

在模型使用过程中,毒性污染是一个严重的潜在风险。Google DeepMind 团队在 Gemini 2.5 的技术报告中详细记录了一个典型案例:当该系统在《宝可梦》游戏环境中运行时,一旦任务目标描述被幻觉信息污染,代理就会持续执行完全错误的游戏策略,这种现象被研究人员称为”语境中毒”。

注意力分散是另一个值得关注的问题。实验数据表明,当上下文长度超过 10 万 token 这个临界点时,智能代理会表现出明显的性能退化,它们更倾向于机械重复历史动作,而不是进行创新思考。Databricks 的研究团队通过严谨的实验进一步发现,即使是性能强劲的 Llama 3.1 模型,在上下文达到 32K 左右时,其回答正确率就开始呈现下降趋势。

在工具使用方面,工具混淆问题同样不容忽视。伯克利大学发布的函数调用基准测试揭示了一个有趣的现象:当提供给 Llama 3.1 8B 模型的工具数量超过 19 个时,其任务准确率会出现高达 40% 的显著下降,这说明过多的选择反而会降低模型的决策质量。

最复杂的挑战来自语境冲突。微软研究院与 Salesforce 的联合团队通过精心设计的实验证明,当信息被分阶段而非一次性提供给模型时,整体性能平均会下降 39 个百分点。这种性能损失的主要原因是模型在早期阶段形成的错误假设会持续影响后续的推理过程。

这些现象共同验证了”古德哈特定律”在 AI 领域的特殊体现——当工程师们将长上下文窗口作为主要优化目标时,这个指标本身反而会发展出各种非预期的失效模式,最终影响系统的实际表现。

3.构建健壮语境系统的三大支柱

- 动态上下文组装技术

现代 AI 系统需要处理多模态数据转换这一关键技术挑战,目前最先进的解决方案是采用 BLIP-2 等视觉语言模型,这类模型能够准确地将图像内容转换为结构化的文本描述;同时,对于结构化数据,工程师们普遍采用 Markdown 语法来重构表格数据,这种方法不仅保留了原始数据的组织结构,还显著提升了模型的理解准确率。

在信息处理方面,优先级排序算法发挥着至关重要的作用,基于信息熵的评分系统能够智能地评估每个数据片段的重要性,确保最关键的信息始终占据上下文窗口前 4K token 的黄金位置,这个区域被证明是模型注意力最集中的部分。

面对长文档处理的挑战,实时压缩技术提供了有效的解决方案,特别是 ICAE(In-Context AutoEncoder)编码器的应用,它能够在保持语义完整性的前提下,将 128K 的长文档压缩 75% 的显存占用,这项突破使得处理超长文本不再受硬件限制。

- 记忆架构设计

短期记忆系统的设计借鉴了 Transformer 架构的 KV 缓存机制,这种设计可以高效地保留最近 10 轮对话的完整上下文,确保会话的连贯性,同时将内存占用控制在合理范围内。

在长期记忆存储方面,现代 AI 系统普遍采用向量数据库技术,这种方案不仅能存储用户的历史交互数据,还能实现高效的语义检索;MemGPT 系统更是创新性地引入了类似操作系统的换页管理机制,实现了记忆资源的智能调度。

反思机制的引入显著提升了系统的学习能力,通过在对话结束后自动生成结构化的”经验文本”,并将这些经验存储到知识库中,实验数据显示这种设计可以使重复错误率降低 30%,大大提升了系统的持续学习能力。

- 工具协同治理

为确保系统安全性,沙箱机制被广泛应用于工具调用场景,当系统检测到高风险 API 调用请求时,会自动触发二次确认流程,这个设计有效防止了误操作导致的安全事故。

白名单控制系统通过精细的角色权限管理,实现了工具访问的精准控制,不同级别的用户和代理只能访问其角色对应的工具集合,这种设计既保证了灵活性又确保了安全性。

在工具互操作性方面,MCP 协议(Model Context Protocol)的标准化工作取得了显著进展,这个基于 JSON-RPC 的接口规范已经得到了业界的广泛认可,目前已有超过 300 个开源工具完成了适配,形成了一个日益丰富的工具生态系统。

4.未来战场:从技术突破到伦理平衡

医疗健康领域正在成为全链路智能体技术的前沿试验场,这些系统创新性地整合了多项关键技术:通过 RAG(检索增强生成)技术实时检索最新的临床指南和医学文献;利用长期记忆系统持续跟踪患者的完整病史;采用多代理协作架构模拟真实的医疗团队协作,其中不同的 AI 代理分别扮演医生、药师和护士等专业角色。临床试验数据表明,这种创新的架构设计已经实现了 28% 的诊断准确率提升,同时将用药错误减少了 47%,展现了巨大的应用潜力。

然而,这些技术进步也带来了严峻的隐私挑战,业界正在积极应对。目前联邦学习结合同态加密的”可计算不可读”方案已经成为主流隐私保护范式,最新的技术突破已经能够在 10 毫秒内完成加密向量的相似度计算,在保证隐私安全的同时几乎不影响系统响应速度。正如著名 AI 伦理学家 Timnit Gebru 所预言的那样:“下一代人工智能的竞争,本质上将是语境治理能力的竞争,谁能在技术创新和伦理约束之间找到最佳平衡点,谁就能赢得未来。”

语境工程正在深刻重塑人机协作的底层逻辑,这种变革不仅体现在技术层面,更影响着整个产业的发展方向。当我们站在 2025 年这个时间节点回望过去几年 AI 技术的发展轨迹时,可能会发现一个有趣的现象:那些真正改变世界的 AI 应用,其成功关键往往不在于拥有最强大的基础模型,而在于是否拥有一支深谙”语境交响乐”之美的工程师团队,他们懂得如何精心编排各种语境要素,创造出和谐高效的智能系统。