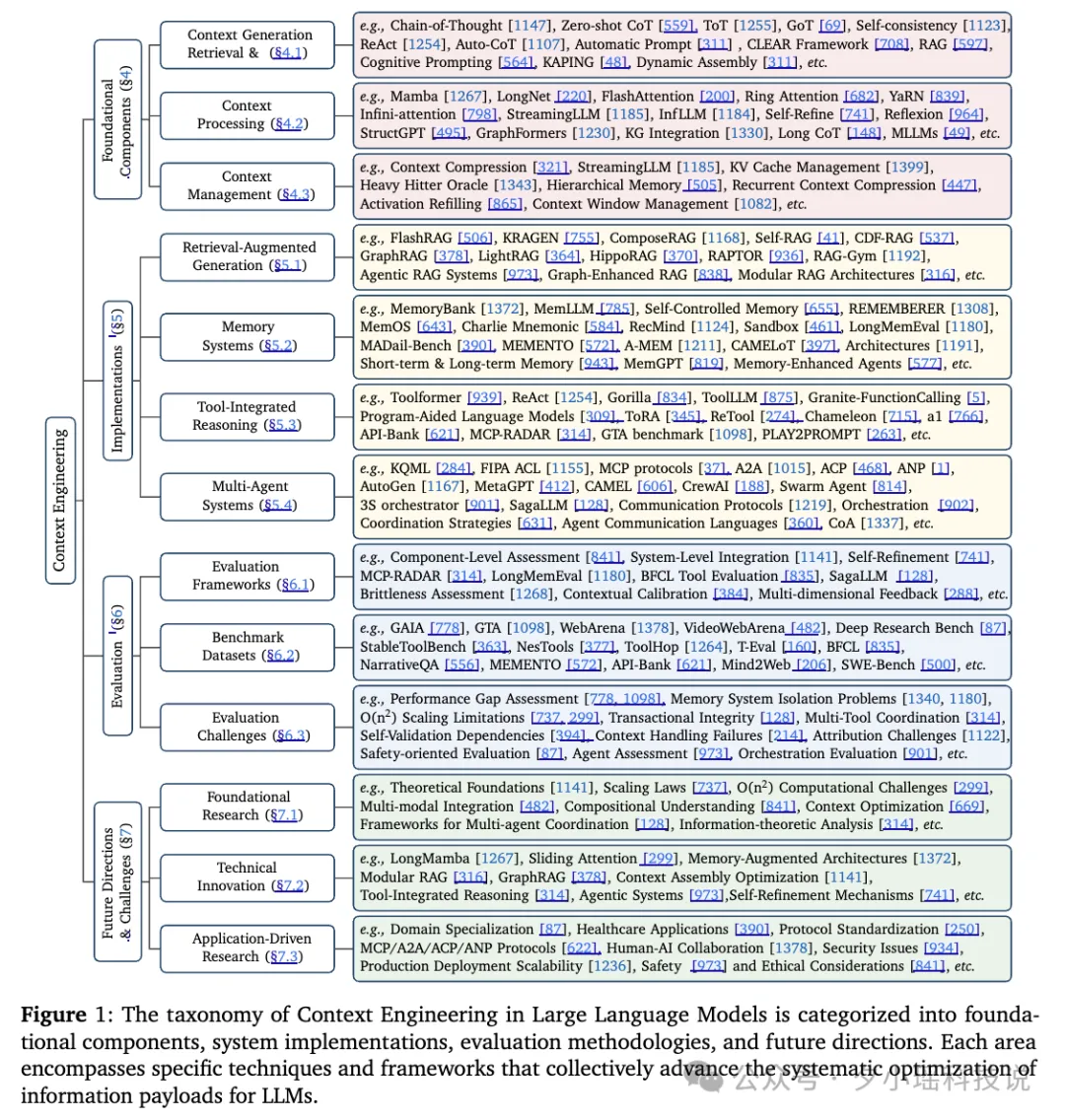

1. 为什么提出“上下文工程”?

1.1 传统提示工程的局限

传统提示工程把“上下文”视作一段一次性写死的字符串。工程师凭借经验在提示里增删示例、调整措辞或增加约束,以期在单次推理中得到最佳结果。然而,当任务需要持续对话、引入外部知识或跨会话记忆时,这种静态字符串的范式立即暴露出明显瓶颈:提示长度迅速膨胀,人工调参成本指数级上升;任何新的外部信息都必须被硬塞进同一段文本,导致关键信号被淹没;模型无法区分“历史信息”与“当前指令”,经常出现“顾前忘后”的幻觉。因此,传统提示工程在面对复杂、长周期、多模态的现实任务时显得捉襟见肘,急需更系统化的替代方案。

1.2 上下文工程的核心定义

上下文工程将“上下文”重新定义为一套可插拔、可演化的信息组件集合,包括系统指令、外部知识、工具描述、长期记忆、环境状态与用户实时查询。这些信息首先由各自的专用函数(检索器、记忆读取器、工具解析器等)独立生成,再通过一个高阶“组装函数”A 动态整合成最终输入。与此同时,整个组装流程本身被视为可优化的对象:在给定任务分布 T 下,寻找最优的函数集合 F*,使得大模型输出的期望奖励最大化。这一视角把提示设计从“手工艺术”升级为“系统工程”,为后续模块化、自动化和可解释优化奠定了理论基础。

2. 上下文工程的三大技术支柱

2.1 上下文检索与生成(Context Retrieval & Generation)

核心问题:如何动态组装最相关的信息?

2.1.1 提示工程的进化树

Zero-Shot CoT 通过一句“Let’s think step by step”触发链式推理,无需任何示例即可将 GSM8K 数学题的准确率一次性拉升约 61%,证明了触发短语本身即可激活大模型的隐式推理能力。Tree-of-Thought 在此基础上把推理步骤组织成搜索树,允许模型在不同分支之间回溯、剪枝和择优,最终在“24 点”游戏任务里把成功率从 4% 提高到 74%。Graph-of-Thought 进一步放宽结构限制,用任意有向图表示步骤之间的依赖关系,平均带来 62% 的质量提升与 31% 的成本下降,为复杂推理提供了更灵活的结构化空间。Self-Refine 则利用同一模型生成、批评与修正,迭代三轮即可在写作任务中带来约 20% 的绝对提升,展示了零训练自我改进的潜力。

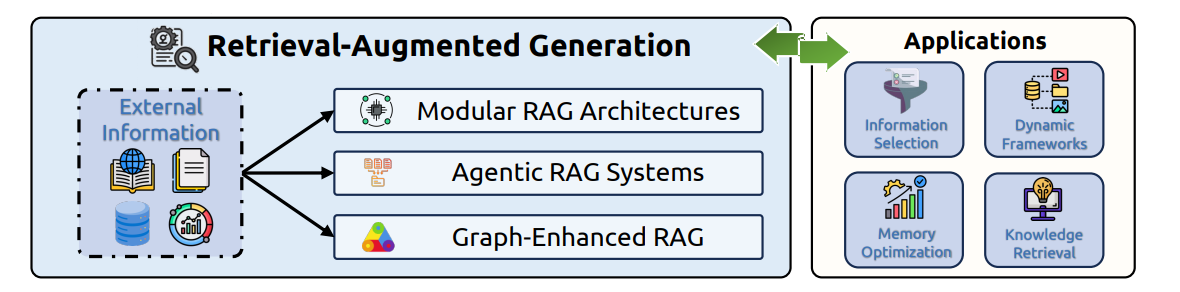

2.1.2 RAG 的三次迭代

Naive RAG 采用最简单的“检索 - 拼接 - 生成”流程,将检索到的文档直接拼在提示后,一次性输出答案,但常因检索不准导致幻觉。Advanced RAG 在检索前引入查询重写、同义词扩展与多路召回,在检索后用交叉编码器重排段落顺序,显著提升了相关性与事实一致性。Modular RAG 将整条链路拆成路由、检索、重写、重排、生成、反思六大可插拔模块,开发者可按任务自由拼装,甚至对单个模块进行微调或强化学习;例如生物医学场景中的 KRAGEN 系统,先用知识图谱定位疾病 - 药物关系,再用向量库召回最新论文,最后让 LLM 生成带引用的诊断建议,整体幻觉率降低约 40%。

2.1.3 动态上下文组装

在现实业务中,用户输入往往同时包含文本、表格、图片甚至视频。动态组装引擎首先将异构数据统一转换成 LLM 可读的 token 序列:表格被渲染成 Markdown 或 SQL 语句,图片通过 BLIP-2 生成自然语言描述,视频先抽关键帧再按时间线展开。随后,优先级排序器基于信息熵、用户画像和任务目标为每段内容打分,确保最关键的信息始终落在上下文窗口的前 4 K tokens 内;如果上下文超限,压缩器会调用 ICAE 或 RCC 算法对早期段落进行摘要式压缩,从而在不丢失核心语义的前提下维持推理质量。

2.2 上下文处理(Context Processing)

核心问题:如何高效处理超长、多模态、结构化数据?

2.2.1 长文本处理技术对比

FlashAttention-2 通过 GPU 内存层级优化与计算 - 通信重叠,将自注意力的显存占用降到理论 O(n²) 的下界,使 Llama 3 在单张 A100 上即可处理 128 K tokens 的输入而不会出现 OOM。LongNet 提出了扩张注意力(Dilated Attention)机制,用指数级稀疏注意力模式把序列长度扩展到十亿级,同时保持线性复杂度,为大规模文档理解提供了可行路径。Mamba 则基于线性状态空间模型(SSM),完全抛弃二次注意力,将序列长度的显存占用从 O(n²) 降为 O(n),理论上可以无限延伸而显存保持不变;实验显示在 1 M tokens 的 Path-256 任务上,Mamba 的吞吐量是同等规模 Transformer 的 5 倍。这三种路线分别代表了“工程优化”“架构革新”“数学范式转换”三种思路,开发者可根据场景与资源权衡。

2.2.2 结构化数据处理

知识图谱方面,StructGPT 将图查询封装成 LLM 可调用的函数接口,模型通过“读取 - 推理 - 再读取”的迭代方式在图上进行多跳问答,无需任何额外训练即可在 WebQSP 数据集上提升 15% 的准确率;KARPA 则提出零训练适配策略,通过预规划路径与语义匹配,将图谱中的实体关系直接映射为推理步骤,实现 KGQA 的即插即用。表格处理方面,研究者发现用 Python 代码或 SQL 语句描述表结构,比自然语言模板更能触发 LLM 的结构化推理能力;例如把“找出销售额大于 100 万的地区”写成 SELECT region FROM sales WHERE revenue > 1e6,在 WikiTableQuestions 上的 EM 分数可提升约 8%。

2.2.3 多模态上下文挑战

多模态大模型常出现“模态偏见”:当文本和图像信息冲突时,模型更倾向于相信文本,导致视觉问答中“看图说话”变成“背题说话”。为解决这一问题,研究者提出交叉注意力机制,让文本 token 和图像 patch 在 LLM 的隐空间里进行细粒度对齐;例如 BLIP-2 中的 Q-Former 先对视觉特征做可学习的查询,再与文本特征融合,显著降低模态偏见。对于更长视频,分层处理范式先用视频基础模型抽帧生成字幕,再让 LLM 在字幕序列上做长程推理,从而在 Video-MME 基准上实现与人类相当的时序问答性能。

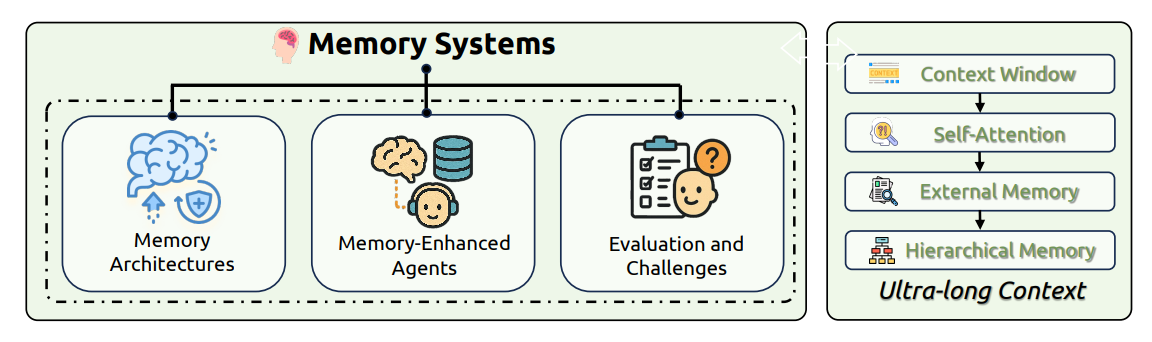

2.3 上下文管理(Context Management)

核心问题:如何存储、压缩、遗忘长期信息?

2.3.1 记忆架构设计

短期记忆依托 Transformer 的 KV 缓存,保存最近若干轮对话的键值向量,会话结束即被清空,适合实时问答。长期记忆则通过外部向量数据库或键值存储实现,ChatGPT 的“会话记忆”与 Google Gemini 的“跨设备记忆”均把用户历史编码成向量,按余弦相似度检索后注入新会话。参数记忆指经过领域微调后固化在模型权重里的知识,可在零样本场景直接调用,但更新成本高;最新研究尝试用 LoRA 或适配器把新记忆以增量方式写入参数,实现“既记新事,不丢旧事”。

2.3.2 压缩技术

In-Context AutoEncoder(ICAE)训练一个轻量级编码器,把长上下文压缩成 4 倍长度的“记忆槽”,解码器仅需读取这些槽即可复原语义,在 128 K tokens 的文档摘要任务上显存节省 75%。Heavy-Hitter Oracle(H2O)观察到 20% 的 token 贡献了 80% 的注意力值,于是按注意力权重淘汰 KV 缓存,推理吞吐量提升 22 倍,同时摘要 Rouge-L 分数保持不变。反思机制方面,Reflexion 在对话结束后用 LLM 生成一段“经验文本”写入记忆库,下次遇到相似任务时先检索这段反思,再进入正式推理,实验表明可减少 30% 的重复错误。

3. 系统级实现:四大工程范式

3.1 检索增强生成(RAG)

在真实业务里,RAG 已从“单路检索 + 拼接”演化为“路由 - 检索 - 重写 - 重排 - 生成 - 反思”的六步流水线。路由模块根据问题复杂度决定是走轻量级向量检索还是重量级知识图谱检索;检索后,重写器用 LLM 将原始段落压缩成要点;重排器再用交叉编码器按与问题的相关度排序;生成器输出答案;反思模块检查是否存在幻觉或遗漏,如有则回到检索阶段补充信息。这套架构在医疗、法律、金融等高知识密度场景中已落地,支持实时增量索引,保证新知识 5 分钟内可被检索到。

3.2 记忆系统

记忆系统把 LLM 从“无状态问答机”升级为“有状态智能体”。ChatGPT 的会话记忆将用户的历史对话总结成 1–3 句话的“个人笔记”,在下次对话时自动注入提示;Google Gemini 更进一步,把同一用户在不同设备上的笔记、邮件、日历事件编码成统一向量,实现跨端连续体验。企业级应用如 MemGPT 则像操作系统一样管理“主存”与“外存”:主存存放当前任务指令与最近 10 轮对话,外存存放压缩后的历史会话,系统根据查询热度自动换入换出,确保显存占用始终低于 8 GB。

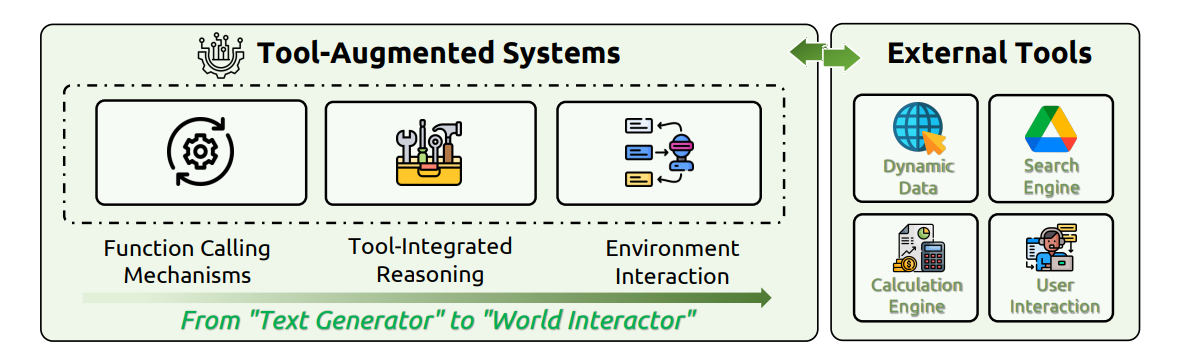

3.3 工具集成推理(TIR)

函数调用(Function Calling)让 LLM 能够直接调用外部工具,如 Python 解释器、SQL 引擎或搜索 API。OpenAI 的 JSON 模式把工具描述转成 schema,模型只需按格式填充参数即可;Granite-20B-FunctionCalling 通过多任务微调,让 20 B 模型在 73 个 API 上的调用准确率超过 GPT-4。对于复杂任务,ReAct 框架让模型交替进行“思考”与“行动”:先写一段自然语言计划,再调用工具,再根据返回结果继续思考,如此循环直到得到最终答案;在 HotpotQA 多跳问答任务上,ReAct 的 F1 分数比纯文本推理提升 18%。

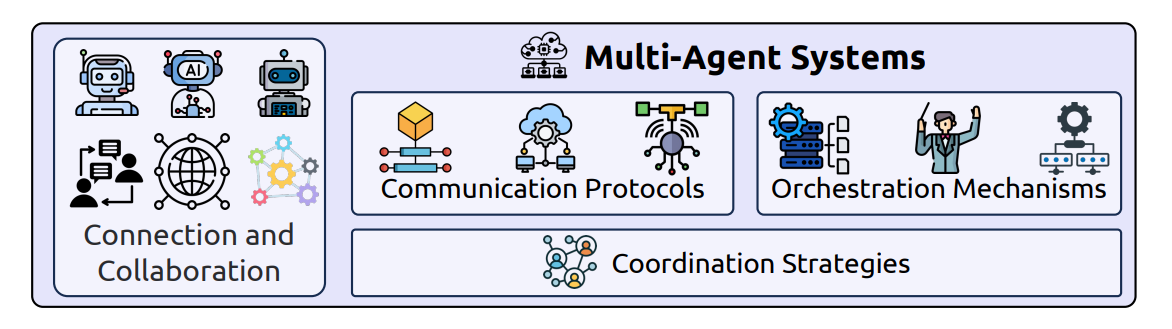

3.4 多智能体系统

多智能体系统通过标准化通信协议让不同 LLM 实例协作完成任务。MCP(Model Context Protocol)像 AI 世界的 USB-C,定义了统一的 JSON-RPC 接口,任何工具只要实现 MCP Server 就能被任意支持 MCP Client 的 LLM 调用;目前已有 300+ 开源 Server,涵盖搜索、代码执行、数据库查询等场景。A2A(Agent-to-Agent)协议则支持点对点通信,允许一个智能体把子任务动态委派给另一个智能体,并在完成时接收回包。AutoGen 框架提供共享消息池和角色模板,开发者只需描述“产品经理 - 架构师 - 程序员”三种角色,系统即可自动生成协作流程,已在开源社区复现了 50+ 复杂软件项目。

4. 评估与挑战:为什么 GPT-4 在 GAIA 上只有 15% 准确率?

4.1 评估困境

传统 NLP 指标如 BLEU、ROUGE 只衡量生成文本与参考答案的表面相似度,无法捕捉多步骤推理或工具调用的正确性。在长文本场景,“Lost-in-the-Middle”现象导致关键信息若放在文档中段,模型检索准确率下降 73%,传统指标却毫不知情。工具调用评测更复杂:一次任务可能涉及 3–5 个 API 的嵌套调用,任何一步参数错误或返回格式不符都会导致最终失败,而现有 benchmark 往往只给出最终答案的 EM 分数,忽略了中间步骤的可解释性与恢复能力。

4.2 关键瓶颈

当前大模型表现出明显的“理解 - 生成不对称”:它们可以准确理解 100 页技术手册的细节,却难以自行产出 10 页连贯且无矛盾的长篇报告。根源在于训练目标——最大化下一个 token 的概率,而非全局规划或事实一致性。此外,LLM 本质无状态,缺乏跨会话的记忆与反思机制,导致在需要长期积累的科研写作、法律合同审查等任务上频繁出现前后矛盾。工具幻觉问题也日益突出:模型在缺乏验证机制时容易调用不存在或参数错误的 API,最新 ToolHop 基准显示,GPT-4 在 995 个多跳工具调用任务上的成功率仅为 34%,远低于人类 92% 的表现。

5. 未来路线图:2025–2030

5.1 技术突破

线性状态空间模型(如 Mamba)用卷积 + 递归替代二次注意力,在 1 M tokens 路径任务上已展现 5 倍吞吐量,未来有望与 Transformer 形成“长短互补”的混合架构;神经符号融合将把 LLM 的语义理解与图神经网络的精确推理结合,实现可解释的多跳知识推理;上下文压缩将逼近信息论极限,研究者正尝试用率失真理论计算“最小可恢复上下文”,目标是 10× 压缩而零性能损失。

5.2 应用落地

医疗领域将出现“诊断 - 处方 - 随访”全链路智能体,RAG 实时检索最新指南,记忆系统记录患者病史,多智能体分别扮演药师、护士与患者家属,协同完成个性化治疗;科研助手将支持“自动文献综述→实验设计→论文撰写”,通过长期记忆跟踪研究假设的演进,并在发现冲突时自动发起新一轮检索;教育场景下,个性化导师会根据学生历年错题与兴趣,动态生成学习路径并调用可视化工具实时讲解。

5.3 伦理与安全

记忆隐私将通过同态加密与联邦学习解决:用户敏感记忆在本地加密后上传云端,模型仅获得“可计算但不可读”的嵌入向量;工具滥用将引入“调用沙箱”与“能力白名单”,任何高风险 API 都需用户二次确认;长期对齐机制将监控模型在持续学习过程中是否偏离人类价值观,计划每季度用宪法 AI 进行“价值观体检”,确保系统始终可控、可信、可用。

6. 评估:如何衡量一个上下文工程系统的成熟度?

评估上下文工程系统,不能再用传统 NLP 的“准确率、BLEU、F1”三板斧。原因在于:

首先,上下文工程系统往往由检索、记忆、工具调用、多智能体协同等异构模块组成,任何一个模块的微小偏差都会在级联过程中被放大,最终表现为整体失败。其次,系统的行为是动态、多回合、跨会话的,静态 Benchmark 难以捕捉其真实表现。

因此,社区提出了“纵向评估”框架:

- 组件级:为检索模块单独计算 Recall@5;为记忆模块测试“一周后仍能正确回忆用户宠物名字”的成功率;为工具调用模块统计“参数提取错误率”和“API 超时后的自愈率”。

- 系统级:引入 GAIA、SWE-Bench、VideoWebArena 等端到端基准,它们要求模型在 2–50 步内完成跨网页搜索、代码调试、视频总结等复合任务,并记录每一步的耗时、Token 消耗和外部调用次数。

- 社会级:用红队对抗方式评估“记忆泄露”“工具越权”等风险,例如让攻击者通过 50 轮对话诱导模型泄露训练数据中的隐私片段。

最新结果显示,GPT-4 在 GAIA 上的成功率仅 15%,而人类可达 92%;在 LongMemEval 测试中,商用对话系统连续对话 1 小时后的事实准确率下降 30%。这些差距成为社区下一步重点攻克的“北极星指标”。

7. 未来路线图:从工程到生态

7.1 技术突破

线性状态空间模型(如 Mamba)已在 1M-token 任务上实现 5× 吞吐,下一步是与 Transformer 组成“混合骨干”,兼顾短程精度与长程效率。神经符号融合将把 LLM 的语义理解与图神经网络的精确推理结合,实现可解释的多跳知识推理。上下文压缩正逼近信息论极限:研究者用率失真理论计算出“最小可恢复上下文”上限,目标是在 10× 压缩比下零性能损失。此外,量子启发式注意力机制与光子芯片的联合设计,有望把 1B-token 推理能耗降到当前 1/10。

7.2 应用生态

医疗场景将出现“诊断 - 处方 - 随访”全链路智能体:RAG 实时检索最新临床指南,记忆库记录患者病史,多智能体分别扮演药师、护士、患者家属,形成闭环式个性化治疗。科研助手将支持“自动文献综述→实验设计→论文撰写”,通过跨会话记忆追踪研究假设的演进,并在发现冲突时主动发起新一轮检索。教育领域将出现“终身导师”,它记住学生 10 年间的错题与兴趣,动态生成学习路径并调用可视化实验工具实时讲解。

7.3 伦理与安全

隐私侧,同态加密与联邦学习将确保“用户记忆本地加密、云端不可读”。工具侧,“调用沙箱 + 能力白名单”会把高风险 API 圈进独立容器,任何越权调用都会触发人工审核。长期对齐方面,计划每季度用宪法 AI 对系统进行“价值观体检”,一旦发现漂移即启动微调回滚。最终目标是建立透明、可审计、可追溯的上下文工程治理框架,让技术始终服务于人类福祉。