(与共绩一起学习人工智能:无代码・轻松无忧系列)第四篇 无代码 AI:如何在共绩算力上运行我的第一个 AI 助手

我为什么想运行自己的语言模型

通过共绩算力平台的无代码预制镜像和灵活 GPU 选择,无需手动配置环境,即可快速启动开源语言模型(如 Qwen3 30B)

支持类 ChatGPT 交互和 API 调用,适合机器学习初学者实践

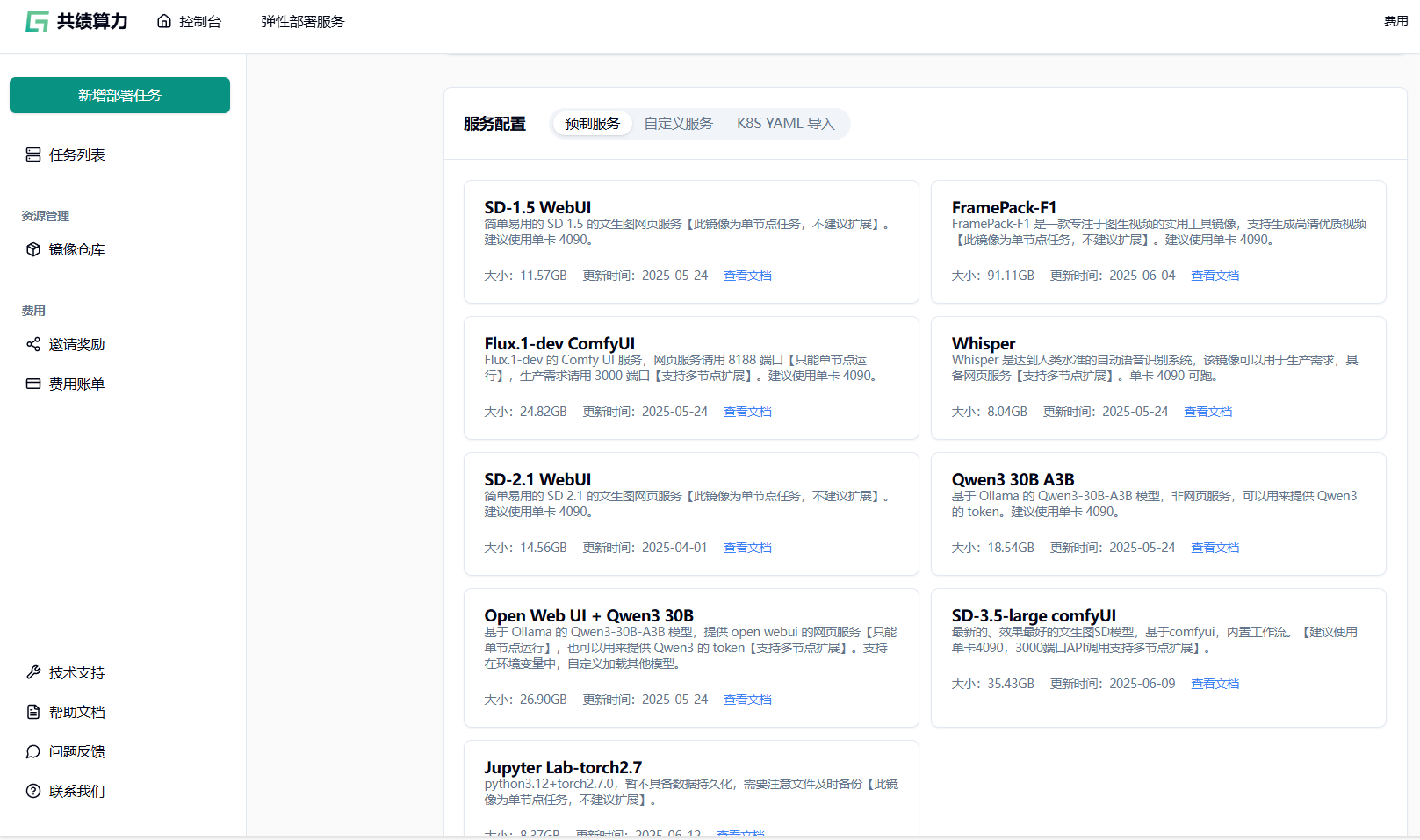

1.共绩算力:立即部署的可试验 AI 模型

文本生成(聊天式交互)使用平台预制服务:

Open Web UI + Qwen3 30B:基于 Qwen3-30B-A3B 大模型的开箱即用聊天界面(通过 8188 端口访问 WebUI),支持类 ChatGPT 交互Qwen3 30B A3B:纯模型服务,提供 API token 支持自定义开发

图像生成(Stable Diffusion 全系列) 多版本预制镜像:入门:

SD-1.5 WebUI/SD-2.1 WebUI单卡快速出图- 进阶:

SD-3.5-large comfyUI- 最新旗舰模型,支持 API 扩展 - 专业:

Flux.1-dev ComfyUI工作流引擎

- 进阶:

开发环境 →

Jupyter Lab-torch2.7:Python 3.12 + PyTorch 2.7 即时编程环境 (适合调试自定义模型,但需注意临时存储特性)

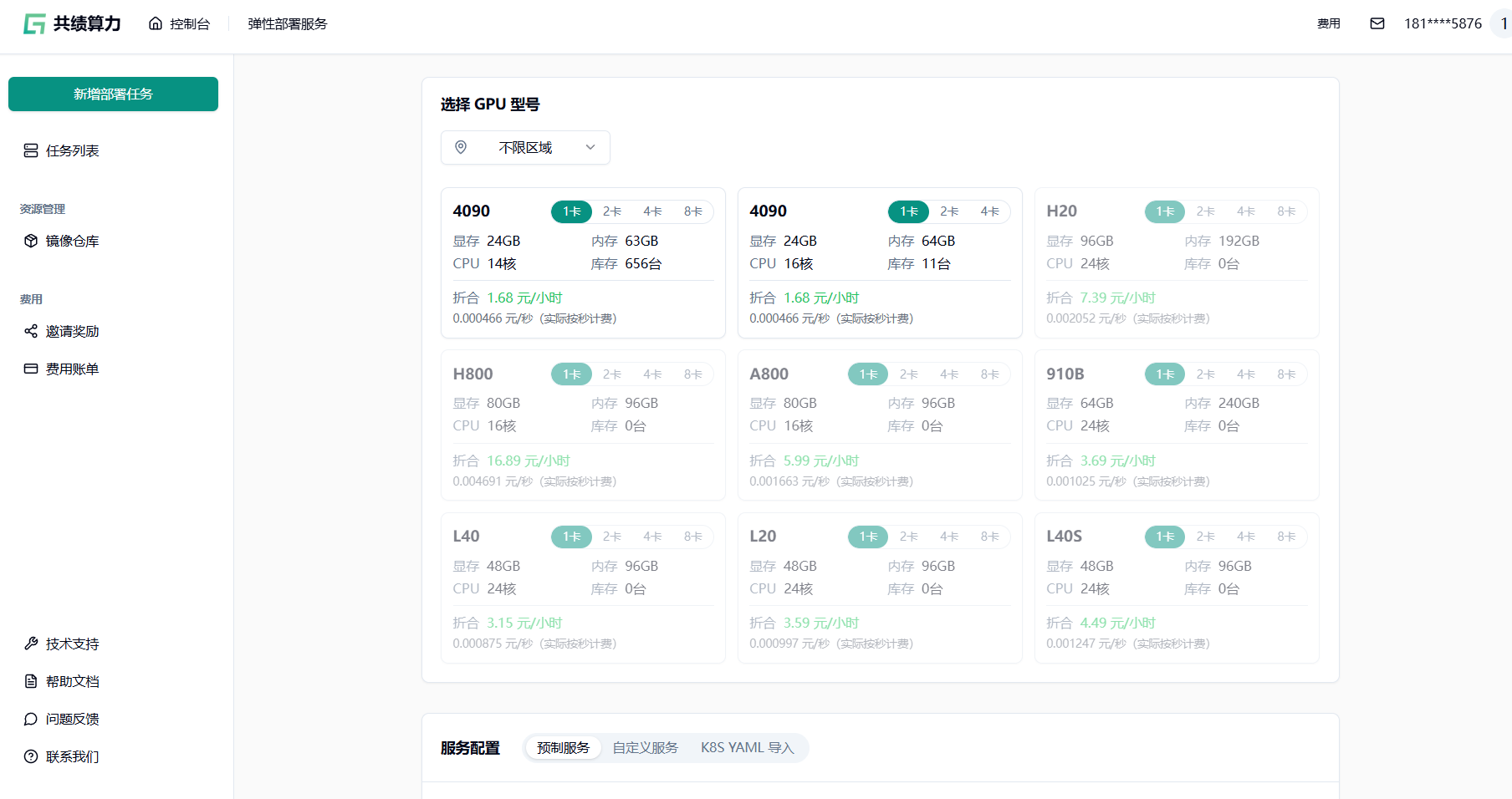

2.如何为 AI 推理选择 GPU

当我在 共绩算力 上启动我的第一个模型(通过“探索”页面)时,我首先感到困惑的是 GPU 类型列表 — A100、H20、4090。我不知道他们中的任何一个是什么意思。这里有一个快速的备忘单:

🟡 4090 – 适合初学者,价格便宜,适用于较小的模型或图像生成。

🔵 H20 – 顶级且快速,但价格更高 – 最适合大型模型或需要快速获得结果的情况。

如果你不确定,可以从 4090 开始。它们对初学者友好,广泛可用,并且适用于大多数入门级任务。

3.循序渐进:在 共绩算力 上部署无代码的 LLM

我为什么选择共绩算力部署大模型?在学习人工智能基础知识后,我希望通过实践更直观地感受大模型的运行逻辑。不同于单纯使用第三方工具,在 GPU Servless 平台上部署开源大模型能让我更深入理解模型特性。共绩算力平台提供的「Open Web UI + Qwen3 30B」预制镜像,恰好满足了我对“无代码、易上手、可扩展”的需求——无需手动配置环境,点击即可启动;支持类 ChatGPT 的对话式交互,边用边学;还能通过环境变量自定义加载其他模型,为后续探索留足空间。

3.1 共绩算力:开箱即用的大模型部署方案

共绩算力平台针对大模型推理场景,提供了「Open Web UI + Qwen3 30B」预制镜像,核心特性如下:

- 无代码交互:通过 8080 端口访问 WebUI,支持类 ChatGPT 的聊天式交互,输入问题即可获得深度回答;

- 标准化 API:11434 端口提供 Ollama 协议的 API 接口,可无缝对接支持该协议的应用程序;

- 灵活扩展:支持通过环境变量切换模型(如 Qwen 3.0 32B 等),适配更多场景需求;

- 资源友好:单卡 4090 即可运行,降低大模型尝鲜门槛;1.68 元/小时 全网最低价格。

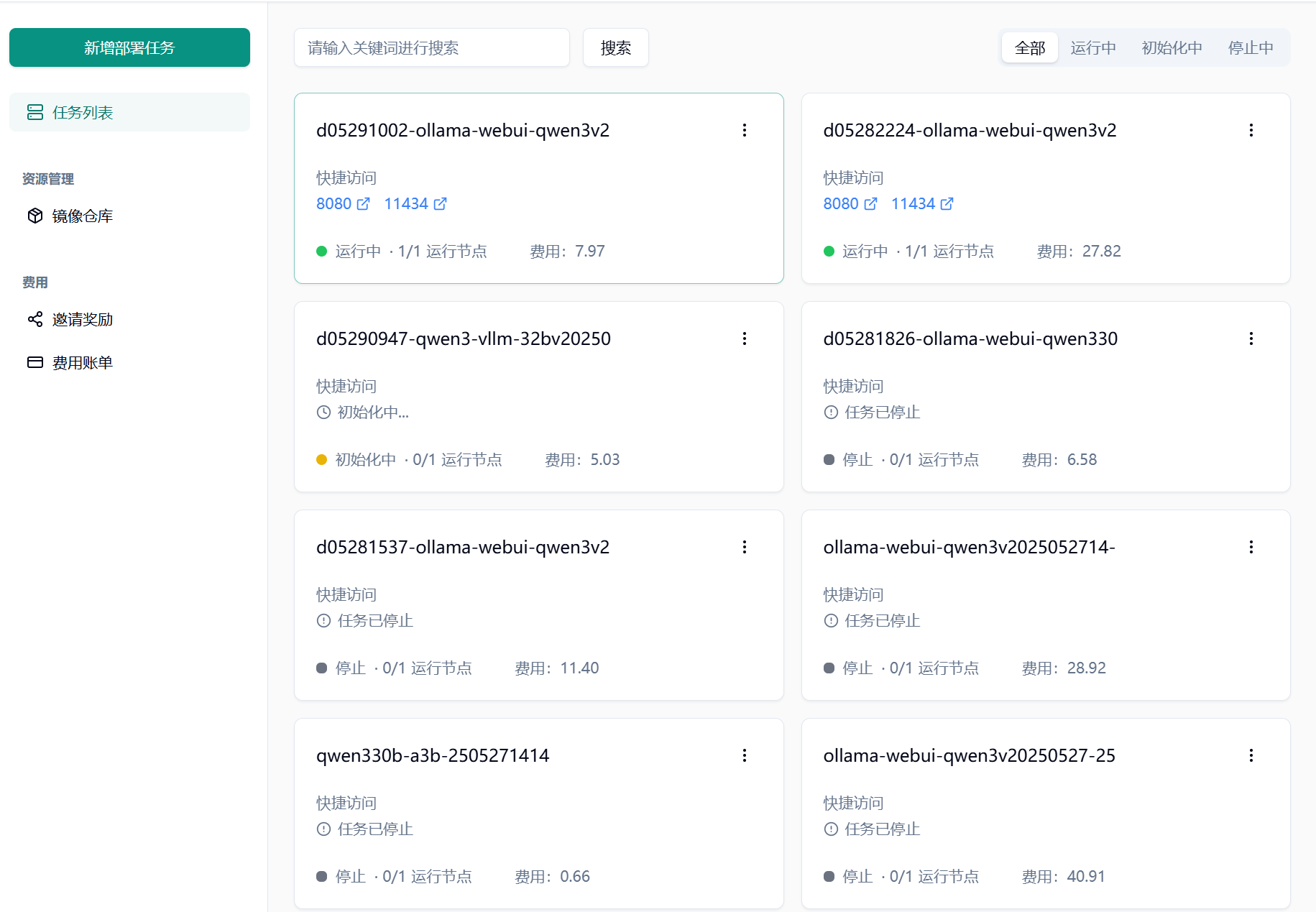

3.2 从零开始部署:5 步完成 Qwen3 30B 大模型启动

- 访问控制台,新建部署任务登录共绩算力控制台(https://console.suanli.cn),点击【新增部署任务】进入配置页面。

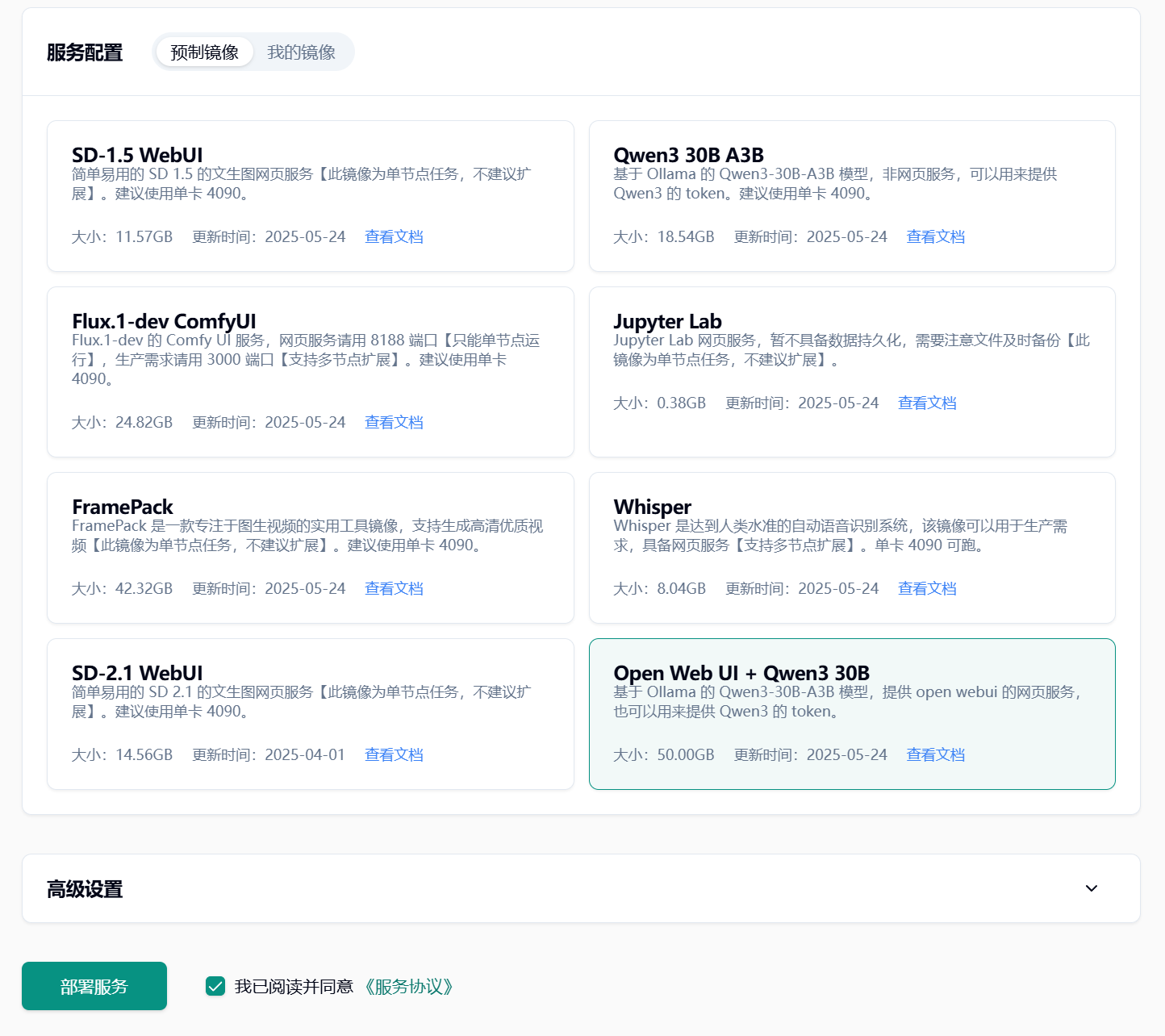

- 选择设备与镜像

- 设备配置:初次调试建议选择单卡 4090、1 个节点;

- 镜像选择:在服务配置中勾选【预制镜像】,选择「Open Web UI + Qwen3 30B」,同意服务协议后点击【部署服务】。

等待镜像拉取与启动由于镜像体积较大(约 30G+),需耐心等待节点拉取并启动镜像,预计耗时数分钟。

完成部署,获取访问链接部署成功后,任务详情页将显示两个关键链接:

API 地址(11434 端口):用于调用 Ollama 服务的标准化接口;

WebUI 地址(8080 端口):用于通过网页与大模型交互。

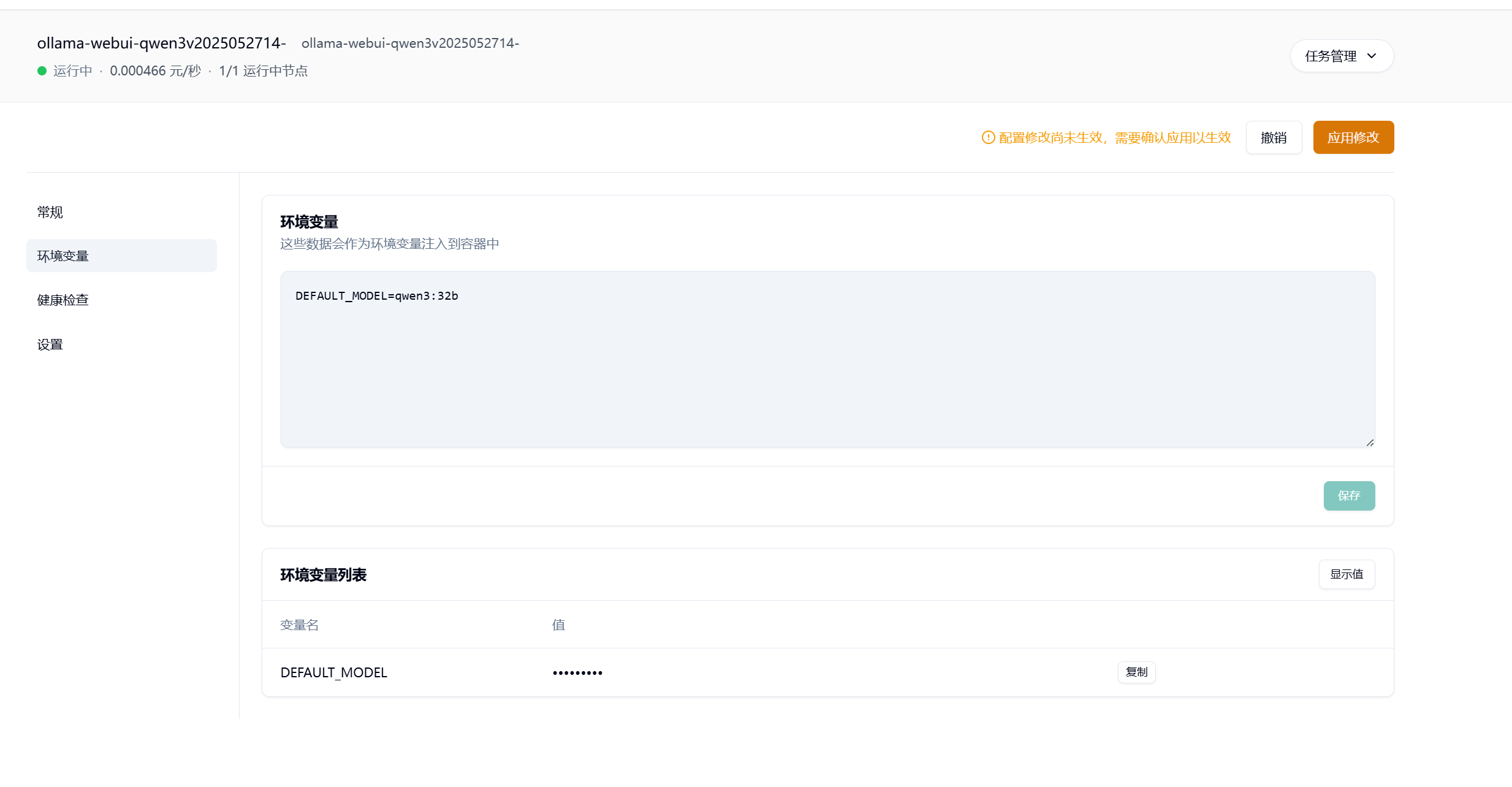

- 切换模型(可选)若需更换模型(如 Qwen 3.0 32B),可通过环境变量快速调整:

进入任务详情页,点击跳转至环境变量设置页面;

输入模型名称(格式:模型系列:参数规模,如qwen3:32b);

点击【保存】并【应用修改】使设置生效。

3.3 开始使用:从创建账号到 AI 对话 1. 访问 WebUI 初始页面

打开 8080 端口链接,进入 Open WebUI 启动界面,点击【开始使用。

设置管理员账号输入自定义的管理员账号和密码,点击【创建管理员账号】完成初始化。

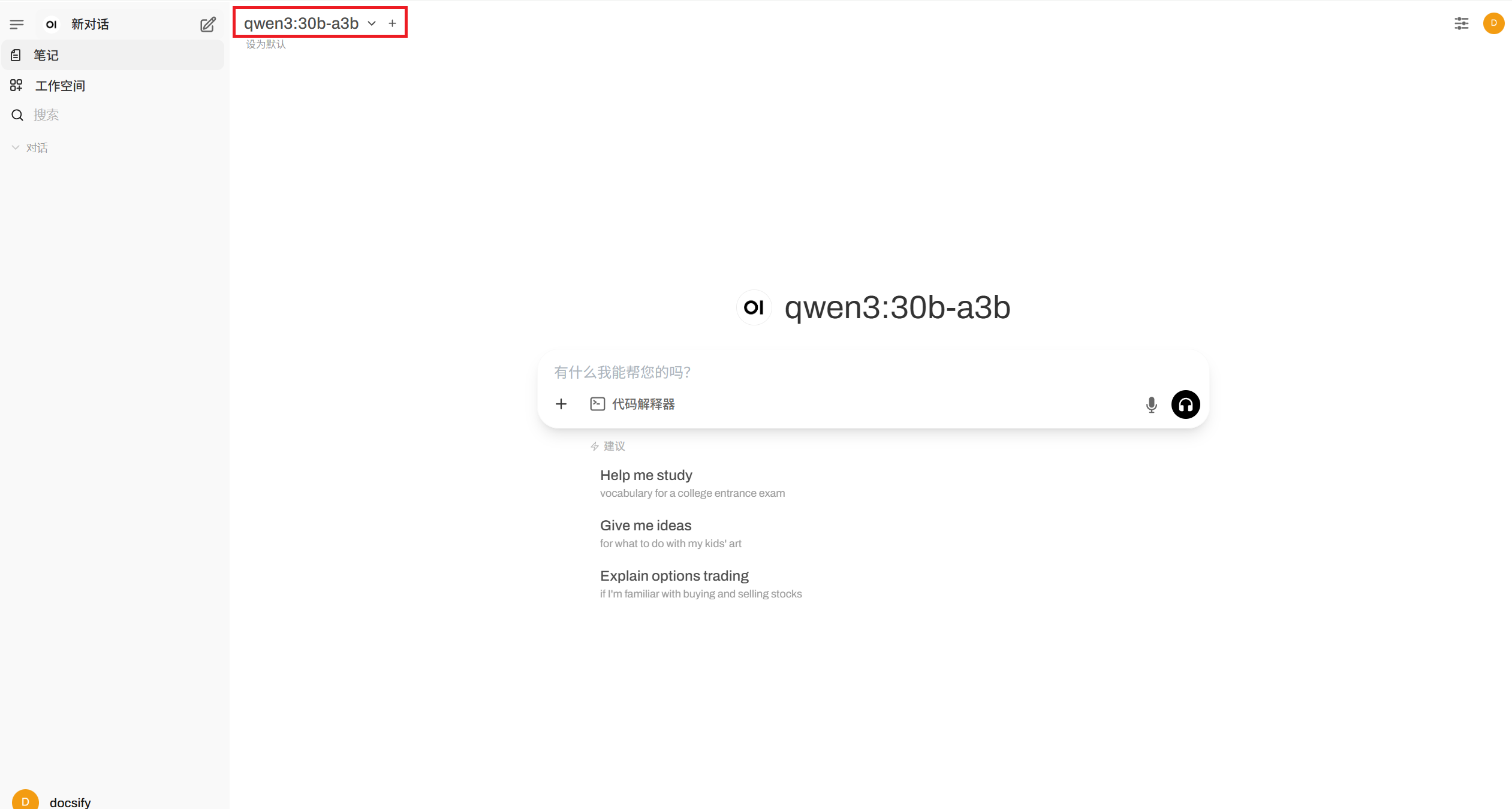

启动 AI 对话账号创建后自动登录,默认加载镜像中的「qwen3:30b-a3b」模型,输入问题即可开启对话。

4.自托管 LLM:我学到了什么

在经历了 GPU 卡选择的纠结、端口混淆的困惑、空白 UI 的迷茫,以及模型加载的等待后,我终于向自己在共绩算力云 GPU 上部署的自托管大型语言模型 ——Qwen3 30B—— 提出了第一个问题。它没有解决“布兰妮与克里斯蒂娜谁更好”的永恒争论,却给出了深思熟虑且礼貌的回应。这不是模板化的“官方回答”,而是真实运行在自己云环境中的 AI 发出的声音。

那一刻,所有的技术名词、部署步骤都不再是抽象的理论。自托管 LLM 不是遥不可及的“黑科技”,而是普通人通过共绩算力这样的无代码平台就能触达的实践 —— 只要你有好奇心、愿意动手尝试,就能成为这场 AI 浪潮的参与者。

5.结束语:使用 AI 学习 AI

机器学习不是魔法,本质是大规模的模式识别。尽管其背后有复杂的数学与工程支撑,但 无需掌握所有细节,你也能从 AI 中受益甚至开启实验。就像用智能手机不必懂半导体物理,开车不必懂内燃机原理 —— 技术的进步,本就是为了降低使用门槛。

AI 最妙的地方在于,它能成为你学习 AI 的工具。我曾在部署时全程开启 ChatGPT 窗口,让它像助手一样引导操作:遇到端口问题时分享截图询问原因,加载模型卡顿时让它解释量化的意义。随着不断互动,你甚至可能为它起个名字,拥有专属的“学习搭子”。

今天,共绩算力等平台提供的“无代码预制镜像”“灵活扩展环境变量”等工具,让 AI 实践比以往更简单。无论你是好奇技术可能性、想验证特定场景,还是单纯想了解重塑世界的 AI 浪潮,现在就是最好的开始时机