(与共绩一起学习人工智能:无代码・轻松无忧系列)第三篇 机器学习:让电脑自己学会思考

你有没有看过围绕 AI 的所有兴奋,然后想:“这看起来很有趣,但我不会编码,所以它可能不适合我”?您并不孤单。机器学习(ML)的世界感觉就像是专为拥有计算机科学学位的程序员构建的。

但好消息是:您不需要编码背景即可了解机器学习的工作原理,甚至不需要开始运行自己的 AI 模型。

当您听到 神经网络、反向传播或梯度下降 等术语时,很容易感到不知所措。关于 AI 的文章通常包含复杂的数学和行话。但从本质上讲,ML 是直观的。把它想象成驾驶汽车——您无需了解发动机的工作原理即可从 A 点到达 B 点。

今天的工具(共绩算力)使无需编码即可探索机器学习成为可能。

1.什么是机器学习?

想象一下,你正在教一个孩子认识猫和狗。你不会一上来就给他讲解猫和狗的生物分类或解剖学结构,而是会给他看许多图片,指着图片告诉他'这是猫'或'这是狗'。慢慢地,孩子就会学会自己分辨猫和狗。机器学习就像是在教电脑做同样的事情。

机器学习是人工智能领域的一个重要分支,它的核心思想是:通过向计算机提供带标签的数据(比如许多猫和狗的图片),计算机可以从中学习并识别出规律,然后用这些规律去处理新的、未知的数据。

2.机器学习的'老师'与'学生'

在机器学习中:

- 数据就是教材:你提供的带标签的数据(如已知是猫或狗的图片)就是计算机学习的材料

- 算法就是学习方法:不同的机器学习算法就像不同的学习方法,有些适合记忆型学习,有些适合理解规律

- 模型就是学生:经过训练的模型就像已经学习了一段时间的学生,它记住了从数据中获得的知识

2.1 AI vs. 机器学习 vs. 深度学习 vs. LLM

- 人工智能(AI):模仿人类智能的机器的广阔领域。

- 机器学习(ML):模型从数据中学习的 AI 子集。

- 深度学习:一种更高级的 ML 技术,使用具有多层的神经网络。

- 大型语言模型(LLM):在海量文本数据集(如 ChatGPT、Mistral 或 LLaMA)上训练的深度学习模型。

2.2 现实生活中的机器学习示例

即使您从未接触过模型,您每天都在使用机器学习:

- 对收件箱进行排序的垃圾邮件过滤器

- Netflix 根据您的观看习惯推荐

- 理解自然语言的语音助手

- 根据您的互动显示内容的社交源

所有这些系统都从数据中学习模式,它们不是用硬编码指令编程的。

3.机器学习任务的类型(它实际上在做什么?)

机器学习本质是模式引擎,其任务类型决定它能解决什么问题。了解这些,你便能快速识别 AI 工具的实际能力:

3.1 分类(Classification) → 贴标签专家

功能:基于历史数据决策分类

场景:

- 图像识别(猫/狗)

- 邮件过滤(垃圾邮件/正常邮件)

- 金融风控(欺诈交易/安全交易)

核心逻辑: “根据已知模式,给新数据打标签”

3.2 生成(Generation) → 内容创造者

功能:学习规律后创作新内容

输出形式:

- 文本(ChatGPT 写文章)

- 图像(MidJourney 绘画)

- 音乐(Suno 作曲)

核心逻辑: “预测下一个元素,串联成完整作品”

3.3 聚类(Clustering) → 模式侦探

功能:在无标签数据中发现隐藏分组

场景:

- 客户分群(电商用户行为聚类)

- 异常检测(信用卡异常消费圈定)

- 市场研究(用户兴趣自然分组)

核心逻辑: “物以类聚,自动归组相似事物”

4.无代码解释 AI 模型

想理解 AI 模型是什么以及它们如何工作,不一定需要敲代码。我们可以用一些日常生活中的类比来揭开它们的神秘面纱。本质上,AI 模型就像是由计算机驱动的、特别擅长识别和预测数据中模式的“智能引擎”。它们不是天生就具备知识,而是像学生一样,通过大量的“学习”(我们称之为“训练”)过程来获得技能。下面我们将一步步拆解这个过程和相关的概念,让你理解其核心思想。

4.1 AI 模型是如何学习的?

回想一下你是如何教一个小朋友识别一只猫的。你不会一开始就给他们讲一堆动物学特征定义,而是会指着真实的猫图片反复说“这是猫”,指着狗的图片说“这是狗”,指着其他不是猫的东西说“这不是猫”。通过不断展示这些清晰的例子,孩子的大脑(就是一个天然的“学习模型”!)会逐渐捕捉到关键的模式:毛茸茸的脸、尖耳朵、胡须、特定的体型等等,最终能够靠自己认出新的猫猫图片。

AI 模型的学习过程本质上和这非常相似,只是它发生在数字世界中,处理的数据量和速度都极其庞大:

数据采集 (Data Collection - Gathering Examples): 首先,你需要为模型准备大量的“教材”。这些教材就是海量、高质量的、已经被“标注”过的数据。想象一下成千上万,甚至数百万张图片,每张图片都明确标注了“猫”、“狗”、“汽车”、“飞机”等等。文本模型则需要海量的文档、书籍、网页内容等。数据的质量和数量对最终模型的能力至关重要,如同孩子的学习需要好的教材和足够的练习题。

训练 (Training - Learning the Patterns): 这是模型真正的“上学”阶段。模型(通常是一个复杂的数学函数或神经网络)会反复“看”这些标注数据。

- 模型看到一个数据(例如一张图片),会根据它当前的理解做一个猜测(例如,它觉得图片里有 70% 是猫,30% 是狗)。

- 系统立刻给它反馈,告诉它正确答案是什么(标注是“猫”)。

- 模型根据这个反馈信息,自动地、细微地调整其内部设置(我们之后会提到的“权重”),目的是下次面对同样或相似的数据时,能做出更正确的判断。

- 这个过程会一遍遍重复整个数据集(通常是很多轮),模型在这种不断的“试错—>反馈—>调整”循环中变得越来越准确,最终学会高效识别或预测数据背后的复杂模式。这就像孩子在无数次的看图识物中越来越熟练。

推理: 模型经过充分训练后,就“毕业”了,可以开始“工作”。这个阶段称为推理。这时,你给它展示它从未见过的新数据(例如一张它训练时没看过的猫图片),它就能运用在训练中学到的能力,快速地进行预测或识别(输出“这是猫”以及可能的置信度)。这就是我们日常使用 AI 时的场景:语音识别、图像分类、智能推荐等。

4.2 AI 模型是如何改进的?

想象模型在训练刚开始的时候。它就像一个刚拿到教材的学生,对里面的知识一无所知。它的最初猜测几乎是随机乱猜的,错误率高得惊人。那么,它是如何一步步变得聪明的?

关键在于模型内部的那些微小的“旋钮”或“刻度盘”——我们称之为权重 (Weights)。模型的核心结构(例如神经网络)由大量的计算节点(类似神经元)连接而成,每个连接上都有一个权重值,决定了信号传递的重要程度。

- 当模型做出错误的预测(比如把猫认成了狗),训练算法就会计算出这个错误有多大,以及哪些权重需要对这次错误“负主要责任”。

- 然后,算法会非常精细地调整这些权重:增大那些让模型更倾向于得出正确答案的连接的权重,减小那些将模型引向错误答案的连接的权重。

- 每一次预测、每一次得到反馈(正确答案),模型都在进行这种权重的优化调整。数以百万、亿计的数据点被处理后,模型内部上百万甚至数十亿个权重都被逐步优化到位,整个模型识别模式的能力(或预测精度)就持续提升了。

- 简单说,模型改进就是模型内部通过反复调整(优化)海量的权重参数,让自己越来越擅长捕捉数据中的关键特征和规律的过程。这就像学生学习后改掉了错误理解,加深了正确印象。

4.3“训练”模型是什么意思?

“训练”这个词在 AI 领域听起来很高深,但其实它的核心概念极其简单,就是大规模、高强度、自动化的“练习”。

重复操作: 模型在训练过程中,会一遍又一遍地将训练数据“喂”给它处理(这个过程通常需要多次遍历整个数据集)。

不断尝试与修正: 每一次处理数据点(如一张图片、一段文本),模型都在进行:

- 预测: 根据当前状态对数据进行猜测(输出一个结果)。

- 评估: 将这个猜测结果与已知的正确答案(数据标注)进行比较,计算出“错误”(损失 Loss)。

- 学习与调整: 然后通过一个关键的数学过程(通常是基于梯度的优化算法,如 SGD),算法会找到如何调整模型的所有权重,使得在下一次遇到相同或类似情况时,这个“错误”能够减小一点点。这个过程就是模型从错误中学习。

目标导向: 所有练习的终极目标就是让模型的预测能力最大化(准确率、召回率等指标)或让预测结果和真实值之间的误差(损失)最小化。

打个生活中的比方:投篮训练。

- 开始时,你可能完全投不中。

- 每次投篮(预测),你会观察球飞行的轨迹和落地位置(评估结果与目标的差距)。

- 根据这次投篮的偏差,你会调整下一次投篮的动作:是力量加大点还是小点?手臂抬高一点还是压低一点?出手角度是往前些还是往上些?

- 经过成百上千次的练习、观察和调整(即多次训练迭代优化),你的投篮动作(模型的权重配置)越来越合理,最终能够达到较高的命中率(预测准确度)。这就是模型训练的本质——持续的练习、反馈和精准的参数调整,直到形成高性能的技能模式。

4.4 为什么机器学习需要如此强大的计算能力?

理解了模型的内部调整(权重优化)是核心之后,强大的计算需求就变得很直观了:

- 巨量的权重: 现代 AI 模型,尤其是深度学习模型(如处理图像的大模型或像 GPT 这样的大语言模型),其内部包含上亿、甚至数千亿个权重。想象一下要同时精密调节上亿个刻度盘!

- 复杂的计算: 每一次对数据的处理(前向传播)、损失计算以及最重要的权重更新(反向传播 + 优化算法),都涉及到极其复杂的、相互依赖的数学运算(主要是矩阵和张量运算)。计算每个权重需要如何调整本身就需要大量的浮点运算。

- 海量的数据: 要让模型学到通用的、鲁棒的模式,需要用到的训练数据集往往极其庞大(以 TB 甚至 PB 计)。模型需要反复多次(多个 Epoch)处理这些海量数据中的每一个样本。

- 速度要求: 如果计算速度太慢,整个训练过程可能需要几个月甚至几年!这显然不实用。现实世界的需求(快速迭代模型、解决实际复杂问题)驱动着对极高计算速度的追求。

总结计算需求来源:

- 规模(Scale): 海量权重 + 海量训练数据 = 天文数字级别的计算任务。

- 复杂度(Complexity): 每一次训练步骤都涉及大量高维度的数学运算。

- 速度(Speed): 需要在可接受时间内完成训练,这要求极强的并行处理能力和内存带宽。

4.4 微调与完整模型训练

在实践层面,我们构建 AI 应用通常有两种核心方法,它们所需的资源和难度相差很大:

完整模型训练(Full Training, Training from Scratch):

- 含义: 从零开始构建和训练一个全新的 AI 模型。这就好比你要自己编写所有教材并亲手教一个完全空白的婴儿从零开始学习一门知识。

- 关键特征:

- 需要极其巨大的、高质量的标注数据集(通常是企业无法自行准备的规模,需要大型开源数据集或巨大的资源投入)。

- 需要非常强大的计算基础设施(成百上千的顶级 GPU 集群)和专业的机器学习工程师来设计模型架构、选择超参数、监控和管理漫长的训练过程。

- 成本极其高昂(数百万美元级或更多),耗时也很长(数周到数月)。

- 主体: 通常由拥有庞大资源和研究能力的大型科技公司或顶尖 AI 实验室(如 OpenAI、Google DeepMind、Meta AI Lab 等) 来完成,以训练出像 GPT 系列、Stable Diffusion、BERT 这样的基础大模型。这些模型在通用能力上很强。

微调(Fine-tuning):

- 含义: 从一个已经训练好的强大基础模型(如 GPT-3, Llama 2, ResNet-50 等) 出发,利用相对较少的数据和计算资源,让这个原本就很“博学”的模型适应你的特定任务需求。这就像请来一个已经精通语言、逻辑、写作的优秀毕业生,然后针对性地教他你公司的业务知识或写作风格,让他变成你的专属专家。

- 关键特征:

- 基于强大的预训练模型(Foundation Model): 直接利用别人花巨资训练好的成果作为高起点,这是微调的核心价值。

- 使用少量专用数据: 你只需要准备与你具体任务相关的、规模相对小很多的标注数据(可能是几百几千条,而非百万级)。例如,让 LLM 生成法律合同,只需提供少量格式合规的法律合同样本;让文生图模型产出你的品牌风格图片,只需提供一些品牌标志和风格的图片。

- 计算需求显著降低: 因为预训练模型已经学习了一般性的知识和模式,微调过程主要是调整模型使其更专注你的特定要求。因此所需计算资源(GPU 数量、训练时间)比完整训练便宜、高效得多。个人或小公司完全负担得起(甚至可以在强力的消费级显卡(G 点算力)上完成小模型或 LLM 特定层的微调)。

- 更易操作和部署: 技术门槛相对较低(有专门面向微调的工具和平台),迭代速度快,能快速产出针对特定需求的解决方案。

4.5 为什么微调如此重要?

它极大地降低了 AI 应用的准入门槛。企业和开发者不需要从头去造轮子(造基础模型),而是可以站在巨人的肩膀上,专注于解决自己领域的具体问题。这是一种高效、实用、可负担的实现 AI 价值的方式。例如:

- OpenAI 花费数千万美元和数月时间从头训练 GPT-4。

- 一个律师事务所可以在一个开源的较小 LLM(如 Mistral/Mixtral 模型)基础上,使用共绩点算力在自己的法律合同数据集上进行微调,几天内就能得到一个能起草高质量专属法律合同的 AI 助手。

- 一个电商品牌可以在一个预训练的扩散模型基础上,用几十张自家产品宣传图微调,快速得到一个生成品牌风格产品图的工具。

微调解锁了将强大基础 AI 模型定制化应用到无数具体场景的关键路径。

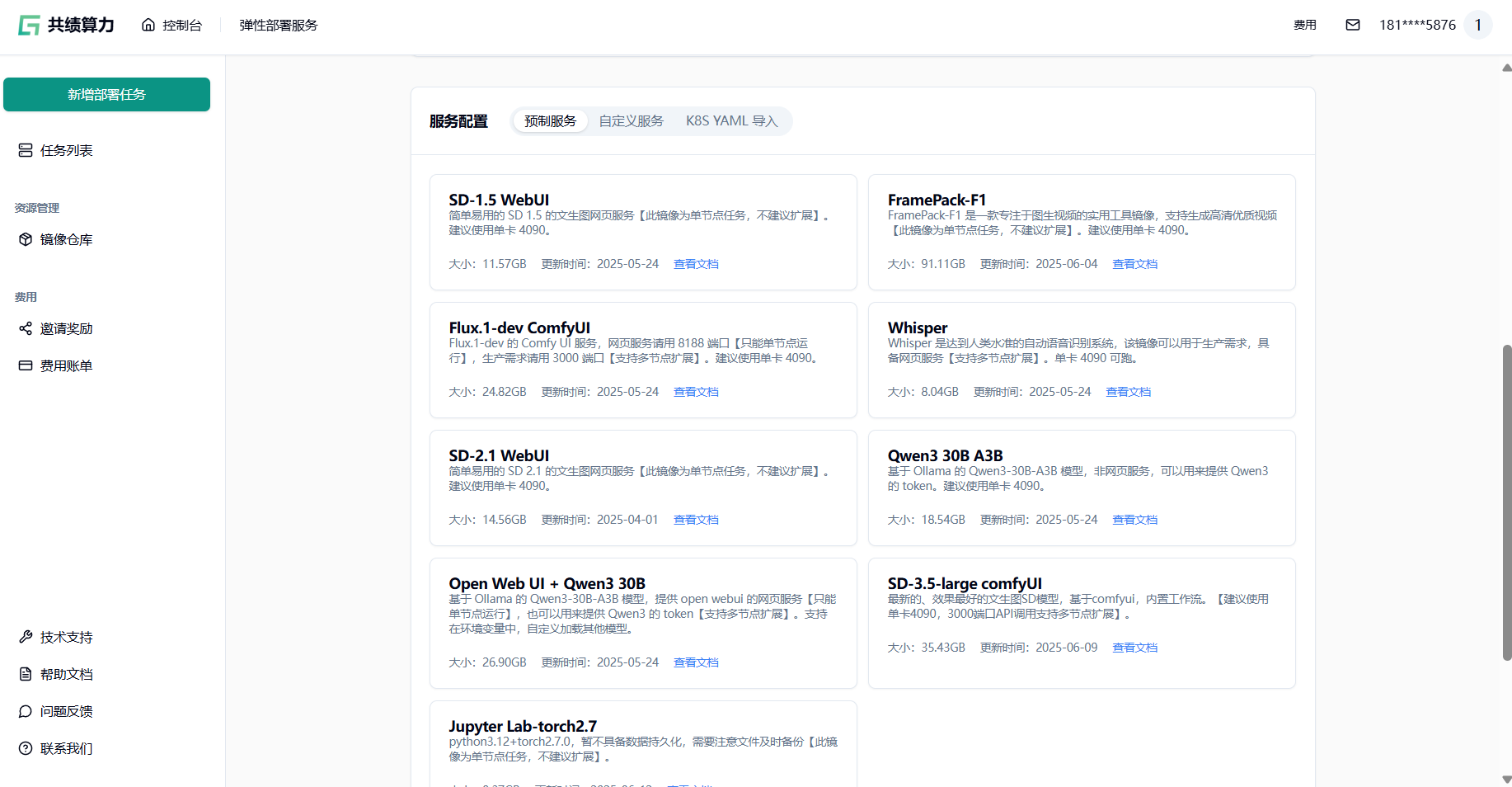

5.即使您不编写代码,也可以边做边学

想尝试 AI 却担心代码门槛?共绩算力平台已为你备好 开箱即用的预制镜像,覆盖主流框架与高频场景,无需手动配置环境,点击即可启动任务,边操作边学习 —— 现在就去 https://console.suanli.cn/serverless/create 探索你的专属镜像!

5.1 场景一:设计师的灵感实验场

“想用 AI 生成概念海报却不会写代码? 试试 「SD-3.5-large ComfyUI」镜像——拖拽内置工作流,输入文字描述,1 分钟产出商业级视觉稿。 边调整关键词边学习提示词精髓,灵感永不枯竭!”

关键点:

- 0 代码门槛 → 直接使用预制工作流

- 边做边学 → 通过调整提示词实时观察效果,积累经验

- 平台优势 → 内置优化模型,生成质量更高

5.2 场景二:短视频创作者的魔法工具

“眼馋电影级动态特效? 打开 「FramePack-F1」镜像,上传一张静态图,3 步生成高清视频片段。 零基础玩转粒子特效与运镜,从‘小白’到‘特效师’只需点几次鼠标!”

关键点:

- 开箱即用 → 专精图生视频的预制工具

- 学习路径 → 通过调整参数(如运动幅度、时长)理解视频生成逻辑

- 性能保障 → 平台优化计算资源(单卡 4090 建议),流畅渲染

5.3 场景三:语言研究者的高效助手

“需要批量转录音频但怕出错? 启动 「Whisper」镜像——上传会议录音,自动输出精准字幕 + 翻译文本。 随用随学:实时调整识别精度,掌握工业级语音处理能力。”

关键点:

- 无代码部署 → 直接运行生产级语音识别服务

- 学习价值 → 通过参数调整(如语言类型、降噪等级)深入理解语音模型

- 平台支持 → 多节点扩展能力应对大批量需求

5.4 场景四:AI 爱好者的第一课

“好奇大模型如何对话? 点击 「Open Web UI + Qwen3 30B」镜像——像聊天一样提问,即刻获得深度回答。 支持自定义知识库上传,玩着玩着就懂了语言模型的门道!”

关键点:

- 学习 0 压力 → 对话式交互自然理解模型能力

- 扩展空间 → 可加载其他模型(环境变量自定义),进阶探索

- 资源友好 → 单卡 4090 运行,低门槛尝鲜大模型

“代码不再是 AI 的门槛——在共绩算力,打开预制镜像,点几下鼠标:生成你的第一张 AI 画作、第一支动态视频、第一次精准语音转录… 动手做的过程中,AI 的奥秘自然解开!”