智谱 AI 最近开源了 GLM-4.1V-9B-Thinking,这是一个 90 亿参数的视觉语言模型,它在复杂推理任务上的表现令人惊艳,某些方面甚至超越了参数量大它近八倍的 720 亿级模型,这无疑是多模态领域一个值得深思的突破。

小模型为何能超越大模型

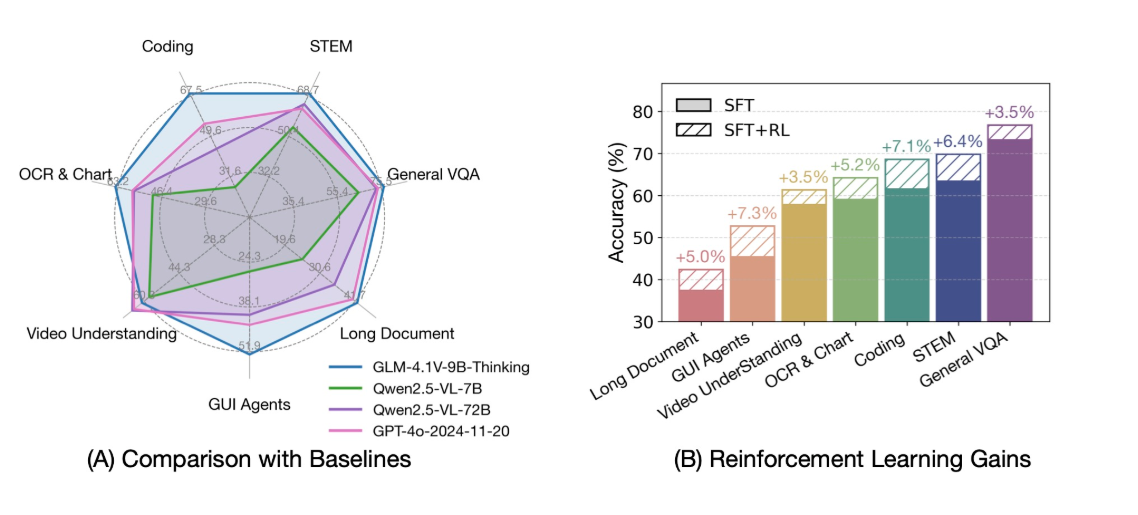

长期以来,我们普遍认为模型参数量越大,能力就越强。然而,GLM-4.1V-9B-Thinking 的出现正在改写这一认知。这款由智谱 AI(THUDM)推出的新模型,通过引入独特的思维范式并结合强化学习进行训练,显著提升了自身的推理能力。我的观察是,这种思维训练让模型不再仅仅是信息的感知者,而开始成为一个真正的思考者。它不仅在数学等特定领域表现突出,在多项综合基准测试中也取得了压倒性优势。

具体来看,GLM-4.1V-9B-Thinking 在 28 个基准任务中,有 23 个取得了 100 亿参数级别模型的最佳成绩,更令人振奋的是,它在 18 个任务上甚至超越了目前行业领先的 720 亿参数模型 Qwen-2.5-VL-72B。这说明,对于高阶推理任务,架构创新和精细的训练策略,其重要性有时可以超越单纯的参数规模。

多模态能力的新标杆

除了强大的推理能力,GLM-4.1V-9B-Thinking 还在多模态处理上树立了新标准。它支持长达 64K 的上下文长度,这意味着模型可以理解并处理更复杂、更连贯的视觉和文本信息。同时,它能处理任意宽高比和高达 4K 分辨率的图像,这对于需要精确细节分析的应用场景至关重要。作为一款双语模型,GLM-4.1V-9B-Thinking 原生支持中文和英文,极大拓宽了其应用范围。智谱 AI 还同步开源了基础模型 GLM-4.1V-9B-Base,鼓励社区在此基础上进一步探索 VLM 的能力边界。

立即体验与探索

对于开发者和 AI 爱好者,智谱 AI 提供了便捷的体验渠道。

你可以在 Hugging Face 或 ModelScope 平台上找到在线演示

Hugging Face 链接:https://huggingface.co/spaces/THUDM/GLM-4.1V-9B-Thinking-Demo

ModelScope 链接:https://modelscope.cn/studios/ZhipuAI/GLM-4.1V-9B-Thinking-Demo

如果你想深入代码,项目的 GitHub 仓库 https://github.com/THUDM/GLM-4.1V-Thinking 提供了详细的快速推理教程和更多开发资源。现在就去体验一下这个以思考为核心的 VLM 吧。