OpenBMB 团队最新发布的 MiniCPM-V 4.5,这款 80 亿参数的多模态大模型(MLLM)在手机上就能实现接近 GPT-4o 的强大能力,特别是对高帧率视频的理解和文档 OCR 性能,为移动端 AI 应用打开了新局面,彻底颠覆了大模型才能有大能力的传统认知。

小参数量跑出大模型实力

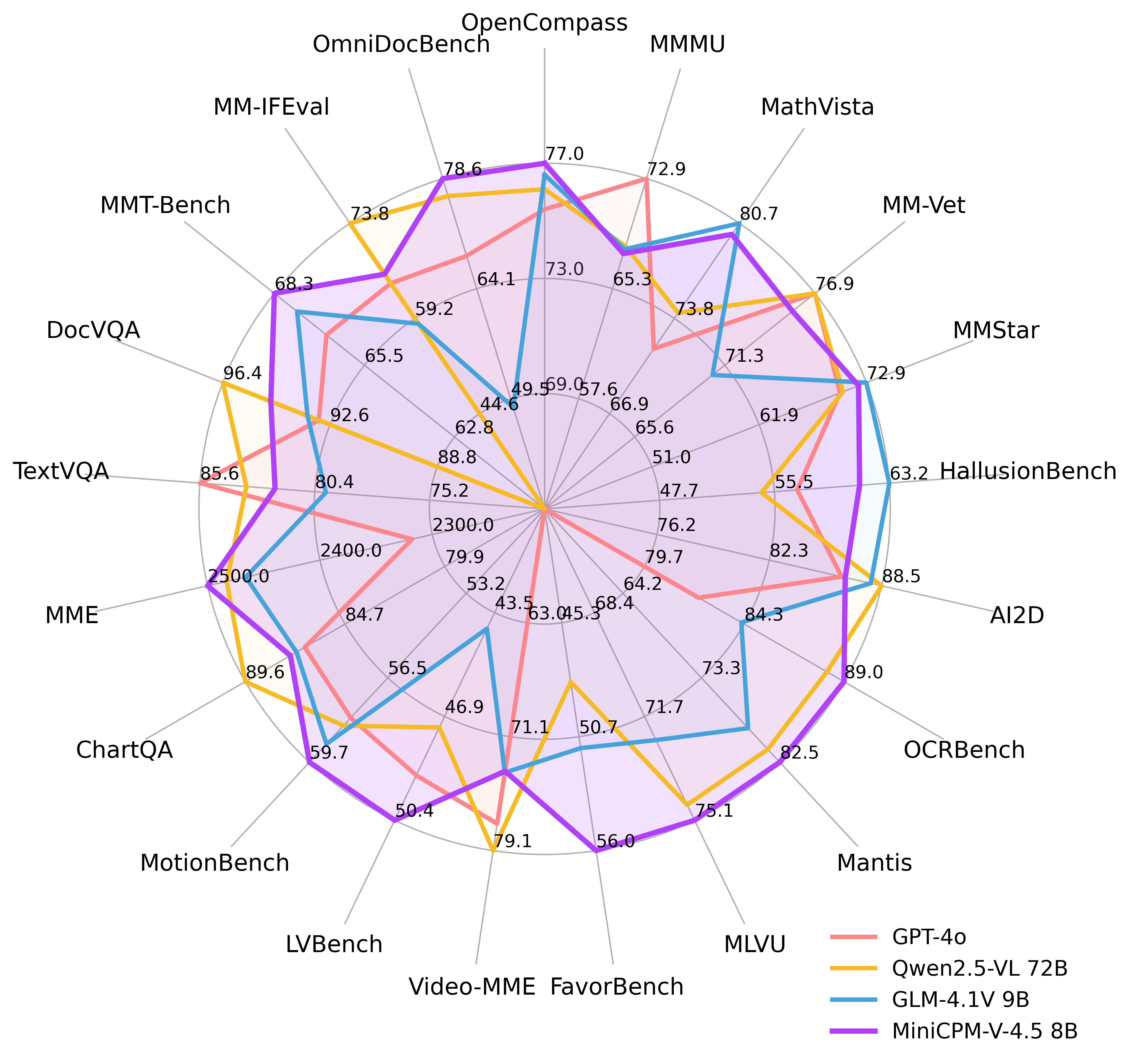

MiniCPM-V 4.5 以其 80 亿参数体量,在 OpenCompass 综合评估中取得了 77.0 的平均分。它不仅超越了 GPT-4o 最新版、Gemini-2.0 Pro 等顶尖闭源模型,甚至比开源的 Qwen2.5-VL 72B 更大参数量模型表现更优,成为 300 亿参数以下最强的多模态模型。

这个成绩着实让人惊艳,证明了在模型架构和训练方法不断优化的今天,参数量不再是衡量模型能力的唯一标准,轻量级模型也能有顶尖表现。

高效视频理解

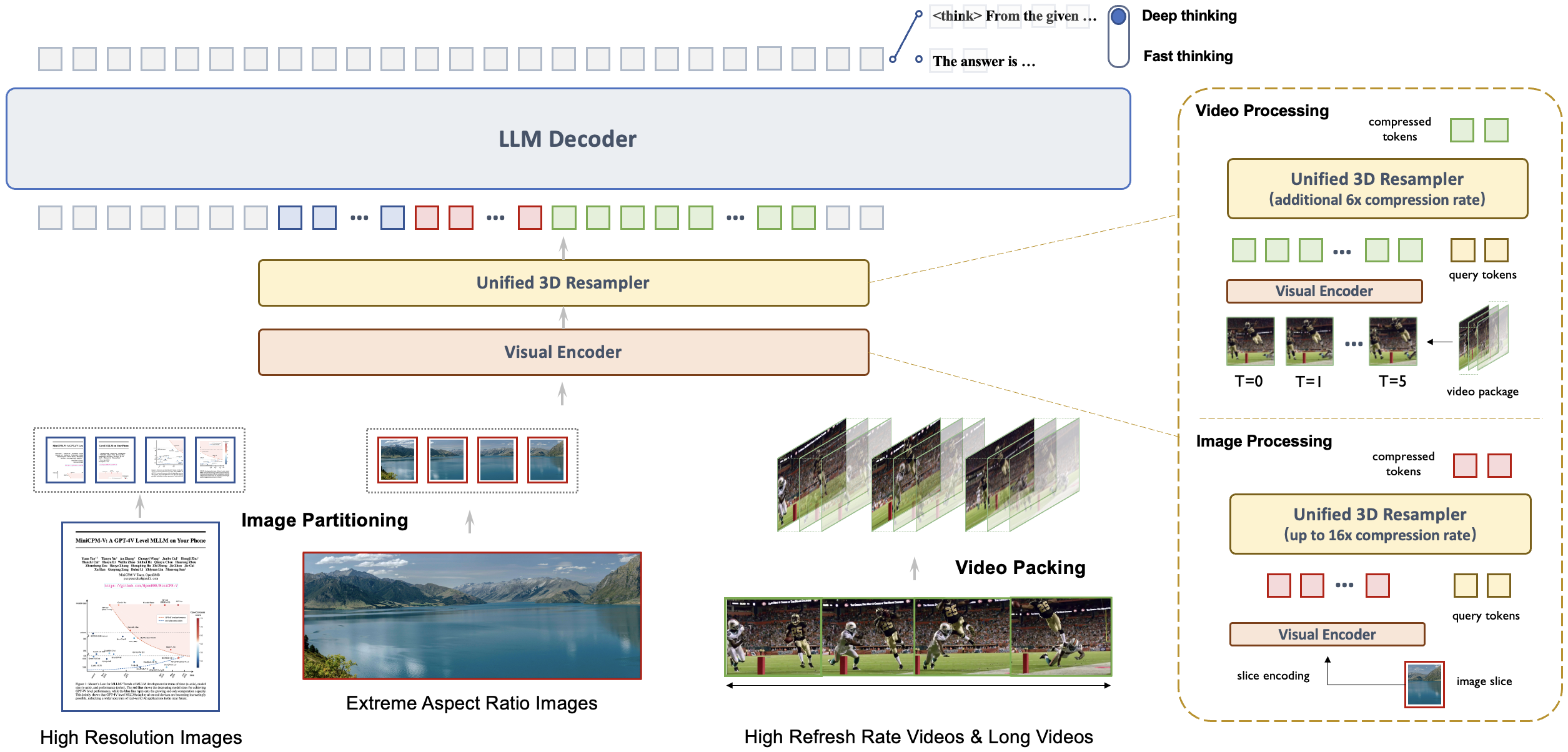

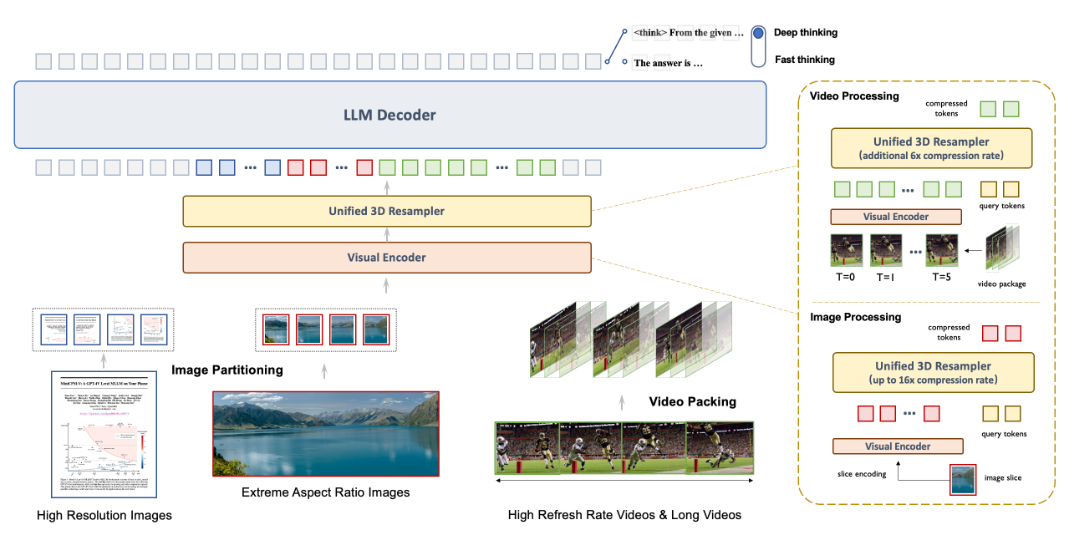

过去多模态模型处理视频的成本高昂,而 MiniCPM-V 4.5 的创新在于引入了统一的 3D-Resampler。这项技术能将 6 帧 448x448 的视频画面联合压缩成仅仅 64 个视觉编码,实现了高达 96 倍的视频 token 压缩率。

这意味着模型在不增加大语言模型推理成本的前提下,可以处理多得多的视频帧,从而实现高达 10 帧每秒的高帧率视频理解,并在 Video-MME、LVBench 等多个视频基准测试中表现出色。这为移动端实时视频分析、短视频内容理解提供了前所未有的高效解决方案。

快思与深思双模式

它提供了独特的快思和深思混合模式。日常高效使用时,可以启用快思模式,在保证性能竞争力的前提下提升效率;遇到复杂问题,则切换到深思模式,进行更深入、更全面的分析。这种可控的模式切换,让模型能在不同用户场景下灵活平衡效率与性能,不再是一个单一维度的黑盒,而是能根据需求调整思考方式的智能伙伴。

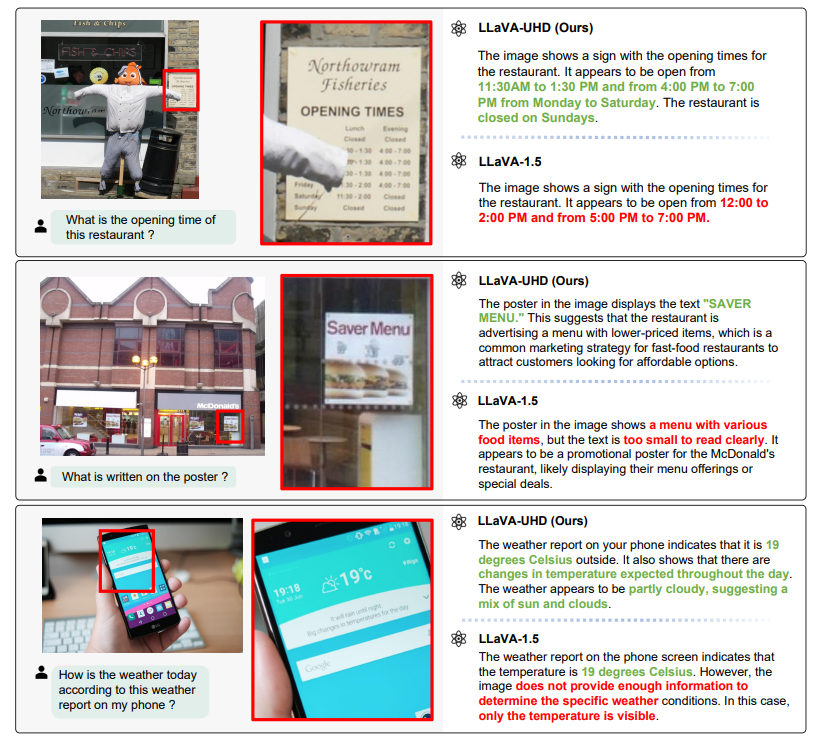

超强 OCR 与多语言支持

基于 LLaVA-UHD 架构,MiniCPM-V 4.5 能处理高达 180 万像素的任意长宽比高分辨率图像,且所需视觉 token 仅为大多数多模态模型的四分之一。它在 OCRBench 上甚至超越了 GPT-4o 和 Gemini 2.5,成为领跑者。

在 PDF 文档解析能力上,它也在 OmniDocBench 通用多模态模型中达到最先进水平。结合 RLAIF-V 和 VisCPM 技术,模型还具备值得信赖的行为表现,并在 MMHal-Bench 上超越 GPT-4o,同时支持超过 30 种语言。

部署与开发友好

考虑到开发者的便利性,OpenBMB 提供了极其丰富的部署和使用方式。你可以通过 llama.cpp 和 ollama 在 CPU 上进行本地推理;有 int4、GGUF、AWQ 等多种量化模型,多达 16 种尺寸可供选择;支持 SGLang 和 vLLM 实现高吞吐量推理;也能基于 Transformers 和 LLaMA-Factory 进行微调,以适应新的领域和任务;甚至提供了本地 WebUI 演示、优化的 iOS 应用(支持 iPhone 和 iPad),以及在线网页 Demo。这些选项大幅降低了开发者将 MiniCPM-V 4.5 集成到各种设备和平台上的门槛。更多详细用法可以在其官方 Cookbook 中找到。

相关链接

GitHub: https://github.com/OpenBMB/MiniCPM-o

CookBook: https://github.com/OpenSQZ/MiniCPM-V-CookBook

在线 Demo: http://101.126.42.235:30910/