微软最近发布了他们的 Phi-4 多模态指令模型,它不只继承了 Phi 系列的轻量级优势,更首次将文本、图像、语音三大模态完美融合到一个模型里。这意味着,过去需要多个模型才能完成的复杂任务,现在一个 Phi-4 就能搞定,而且性能还出乎意料地强劲。这对于资源受限或需要低延迟的应用场景来说,无疑是一项突破性的进展。

一个模型搞定图文音

Phi-4-multimodal-instruct 的核心亮点在于它是一个轻量级的开放多模态基座模型。它基于 Phi-3.5 和 4.0 的语言、视觉、语音研究及数据集构建,能够同时处理文本、图像和音频输入,并生成文本输出,上下文长度达到了惊人的 128K tokens。与之前 Phi 系列需要多个模型组合才能处理多模态任务不同,Phi-4 现在在一个统一的神经网络里实现了多模态联合处理,大大简化了开发流程并提升了效率。

多语言能力全面升级

Phi-4 在语言支持上表现出色,文本模态支持包括中文、阿拉伯语、德语、法语、日语、韩语等在内的 20 多种语言。视觉输入目前主要支持英文,而音频输入则支持英语、中文、德语、法语、意大利语、日语、西班牙语、葡萄牙语等多种语言。这种广泛的语言覆盖使其能够服务于更广泛的全球用户和应用场景。

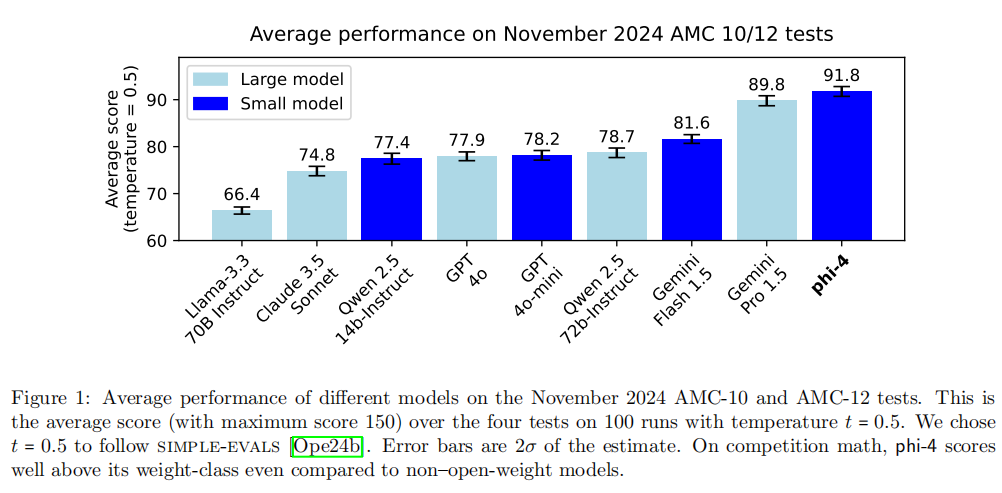

性能炸裂超越大模型

通常我们觉得小模型在性能上总是吃亏,但 Phi-4 多模态模型却在不少关键任务上展现了超越同行的实力,甚至能与一些大模型掰手腕。我尤其感到惊讶的是,在自动语音识别(ASR)和语音翻译(ST)上,它竟然超越了专业级的 WhisperV3 和 SeamlessM4T-v2-Large 模型。

在 Hugging Face 的 OpenASR 排行榜上,Phi-4 以 6.14% 的词错误率(WER)位居第一,打破了之前 6.5% 的最佳记录。更让人惊喜的是,它是首个实现语音摘要的开源模型,而且性能已经非常接近 GPT-4o。这颠覆了我们对小模型能力的固有认知,证明了精巧架构和高质量数据结合的巨大潜力。在视觉方面,Phi-4 在多种视觉任务,特别是图表和文档理解、数学推理等细分领域,表现出强大的能力,在许多基准测试中都名列前茅,甚至在一些多模态视觉 - 语音任务上超过了 Gemini-2.0-Flash 等竞品。

落地场景广阔

Phi-4-multimodal-instruct 特别适合那些内存或计算资源受限、对延迟有严格要求的场景。

它在数学和逻辑推理、函数和工具调用、通用图像理解(例如 OCR、图表和表格理解、多图像比较、视频摘要)、以及语音识别、翻译、问答和摘要等领域都有广泛的应用潜力。它作为生成式 AI 功能构建块的潜力巨大。

快速上手体验

想亲手试试这款强大的模型?微软提供了便捷的体验途径: