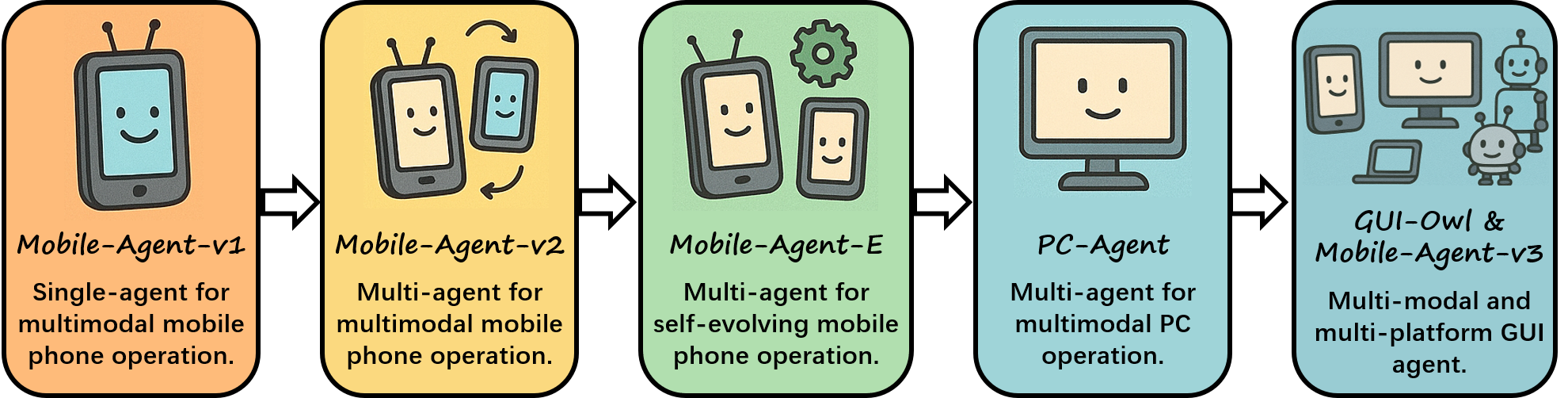

伙计们,快看过来!阿里 Qwen 团队最近搞了个大新闻,推出了两款超酷的 AI 神器——GUI-Owl 和 Mobile-Agent-v3。它们不只是简单的自动化工具,而是让 AI 能像我们人类一样,真正理解、操作手机和电脑的图形界面。

这就像你的设备突然拥有了一个会思考、能学习的数字大脑,而且还能自己越变越聪明,彻底颠覆了传统 GUI 自动化的玩法。

打破传统界限

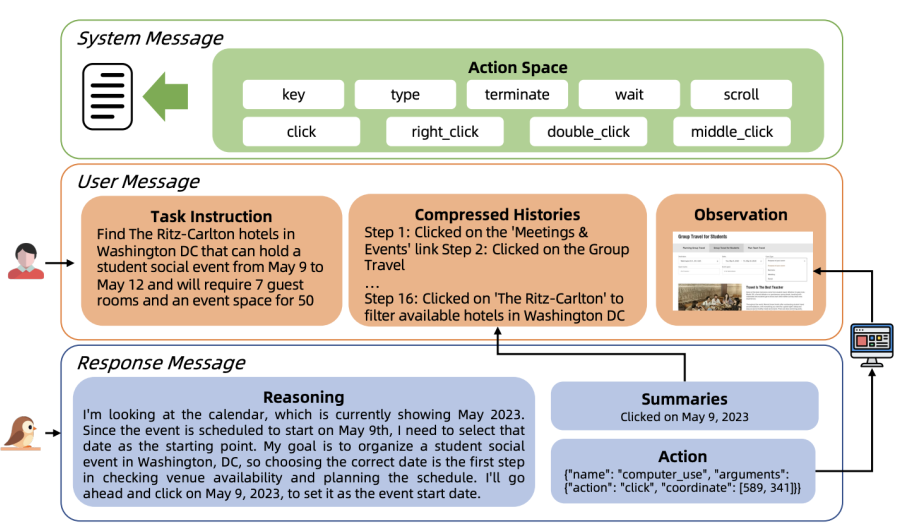

GUI-Owl,它是一个端到端的 多模态代理模型,由阿里 Qwen 团队基于 Qwen2.5-VL 开发并进行了大量定制化训练。你可以把它想象成一个拥有读屏能力和思考能力的 AI,能够统一处理视觉感知、元素定位、任务规划以及动作执行。这意味着,无论是手机 APP、桌面软件还是网页,它都能跨平台无缝交互,甚至进行多轮次的复杂推理。

它最厉害的地方在于统一策略网络,不再像以前那样把感知、规划和执行拆开,而是将这些能力整合到一个神经网络里。这样一来,它就能更灵活地进行多轮决策,并展现出清晰的中间推理过程,应对现实世界中各种复杂和不确定的 GUI 环境。而且,阿里团队还搭建了一套云端虚拟环境,让 GUI-Owl 和 Mobile-Agent-v3 在安卓、Ubuntu、macOS 和 Windows 等系统上自己玩,生成高质量的交互数据,并判断这些操作的对错,形成了一个自进化的训练闭环,让 AI 自己学会如何做得更好。

多代理协作

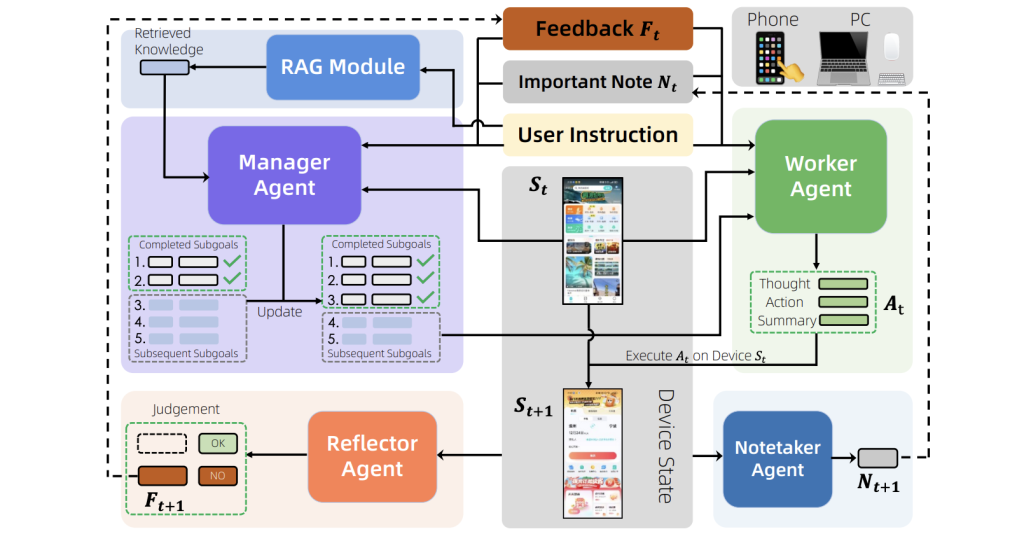

如果说 GUI-Owl 是大脑,那么 Mobile-Agent-v3 就是一套精妙的身体协调系统。 它是一个通用型的多代理框架,擅长处理那些步骤繁琐、跨应用的工作流。

这个框架里有四个各司其职的特工:

- 经理代理:负责把你的高层指令分解成一个个小目标,并根据执行情况动态调整计划。

- 工人代理:在当前界面状态下,执行最合适的子目标。

- 反思代理:评估每一步操作的结果,及时发现问题并提供反馈。

- 笔记代理:记录下重要的信息,比如账号密码、关键数据等,确保即使跨应用也能顺利完成任务。

这种多代理协作的方式,让 Mobile-Agent-v3 在处理复杂、漫长的任务时展现出强大的韧性,能有效应对各种突发情况和错误。

自进化训练

AI 代理开发的瓶颈之一就是高质量训练数据稀缺且昂贵。阿里 Qwen 团队巧妙地通过一个自进化数据生产管道解决了这个问题。简单来说,他们用大模型生成真实的用户操作指令,然后让 GUI-Owl 或 Mobile-Agent-v3 在虚拟环境中模拟操作,生成一连串的动作轨迹。接着,一个两级评论系统(既看每步操作对不对,也看整个任务完成得好不好)会对这些轨迹进行判断。成功的轨迹会被用于后续训练,从而形成一个良性循环,让模型不断自我迭代和进步。这种让 AI 自己产生数据、自己判断对错的学习方式,我觉得比纯粹依赖人工标注的传统方法更具颠覆性,预示着 AI 训练可能会进入一个全新的自给自足时代。

性能实测

在多项 GUI 自动化基准测试中,GUI-Owl 和 Mobile-Agent-v3 的表现让人眼前一亮。

在界面元素定位任务上,GUI-Owl-7B 不仅超越了所有同等规模的开源模型,GUI-Owl-32B 甚至在 MMBench-GUI L2 这样的跨平台测试中,得分超越了 GPT-4o 和 Claude 3.7 等顶尖的闭源模型。这意味着它对 UI 元素的理解和定位能力非常精准,无论是简单的按钮还是复杂的文本区域,都能准确识别。

在更全面的 GUI 理解和单步决策任务中,GUI-Owl-7B 在 MMBench-GUI L1 基准测试的困难级别中取得了 90.9 的高分,遥遥领先现有模型。而在考验端到端、多步骤任务的 AndroidWorld 和 OSWorld 基准测试中,Mobile-Agent-v3 的表现更是刷新了开源框架的记录,尤其在复杂任务中的优势明显,这充分证明了其多代理设计的卓越效果。

GUI-Owl 和 Mobile-Agent-v3 的出现,无疑是通用型自主 GUI 代理发展路上的一个重要里程碑。它们不仅在感知、推理和执行上实现了高度统一,还通过自进化的训练范式,解决了长期困扰 AI 界的数据瓶颈问题。我个人觉得,这种让 AI 能够自我学习、自我进化的机制,才是真正推动 AI 走向通用智能的关键一步。这不只是技术的进步,更是 AI 发展哲学上的转变,未来 AI 代理或许真的能成为我们日常工作生活中不可或缺的智能伙伴。

相关链接

论文链接:https://arxiv.org/abs/2508.15144

GitHub 页面:https://github.com/X-PLUG/MobileAgent