容器化部署通用推理镜像 Ollama 篇

该方式部署模型可能需要一定经验。如无特殊需求,建议使用其他预制镜像

目前平台提供三种通用镜像:vLLM, SGLang ,Ollama。三种镜像均提供 OpenAI 兼容接口。可供多种客户端调用。目前模型默认通过 modelscope 在运行时下载 (ollama 需要指定 modelscope.cn/组织/仓库下载)。

关于镜像选择的简单建议:

高并发 -> vLLM (稳定), SGLang (前沿)

GGUF 模型 -> Ollama

目前 vllm 镜像已经上线预制服务,只需要在 https://console.suanli.cn/serverless/create 选择镜像

【vllm】后点击部署。

修改模型,只需在部署后修改启动命令。可见容器化部署通用推理镜像 Ollama 篇

对于 Ollama 这里推荐选择 GGUF 模型 比如这里的

https://modelscope.cn/models/Qwen/Qwen3-8B-GGUF

此时模型 id 为 Qwen/Qwen3-8B-GGUF

进入 https://console.suanli.cn/serverless/create

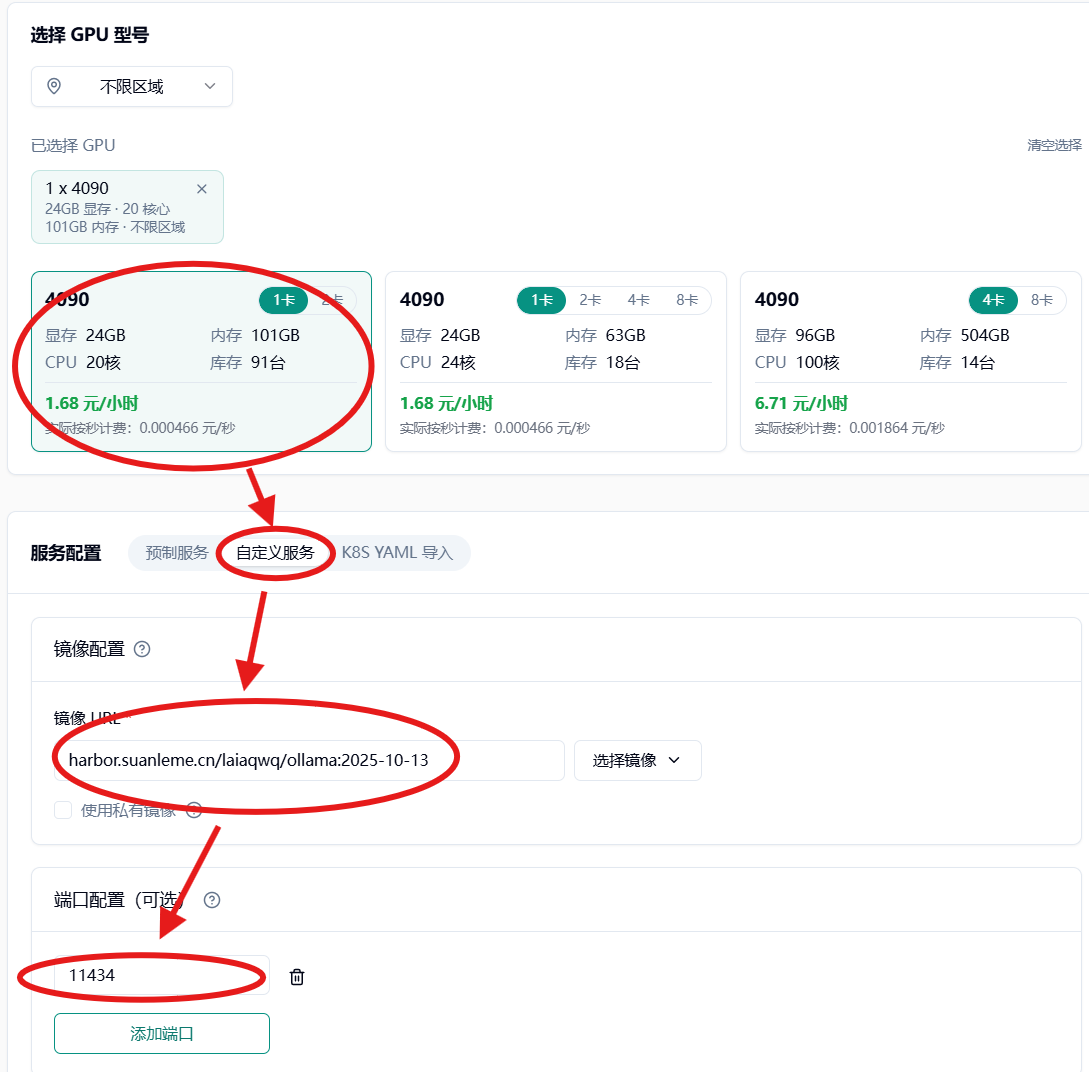

选择 GPU 型号(推荐 4090)也可以根据需求选择其他型号。

下拉至服务配置部分区域。

选择自定义服务->镜像 URL harbor.suanleme.cn/laiaqwq/ollama:2025-10-13 ->

端口配置 11434

配置推理服务

Section titled “配置推理服务”运行命令

/bin/bash

运行参数

-c

ollama serve & sleep 5 && ollama pull modelscope.cn/Qwen/Qwen3-8B-GGUF && wait

具体启动命令请参考:Ollama 加载 ModelScope 模型 https://modelscope.cn/docs/models/advanced-usage/ollama-integration

或是 ollama 文档 https://github.com/ollama/ollama/tree/main/docs

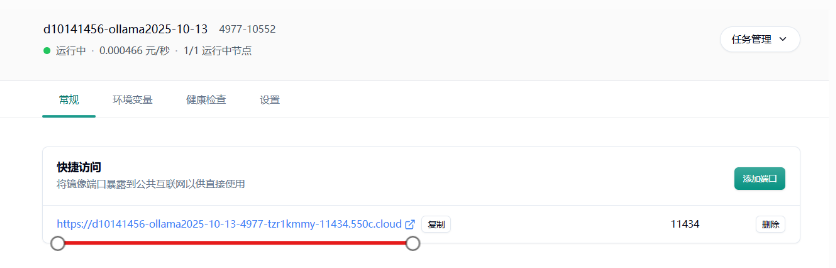

下拉到最下方点击部署服务,等待镜像拉取,模型下载后。即可使用。

启动后

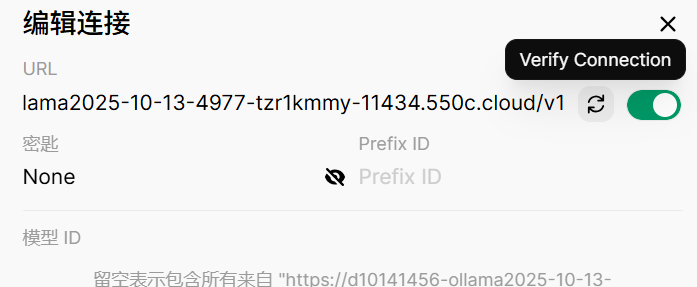

链接/v1 (https://****.550c.cloud/v1) 即为 URL

key 随便填

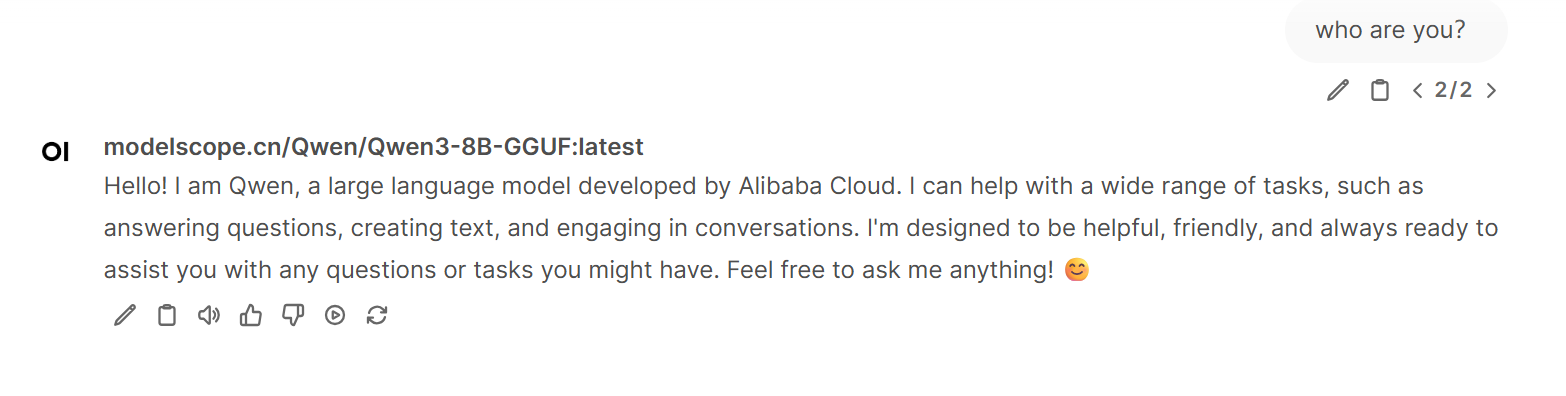

可以看到服务已经正常启动。