思维链提示技术极大地提升了大型语言模型在处理复杂推理任务时的能力。然而,标准的手动构建示例费时费力,难以规模化。

本文将深入探讨思维链的核心思想,剖析现有方法的局限性,并重点介绍一种强大的自动化方法——自动化思维链。读完本文,你将了解它的工作原理、应用场景,以及如何将其与大模型接口结合,发挥出最大效能。

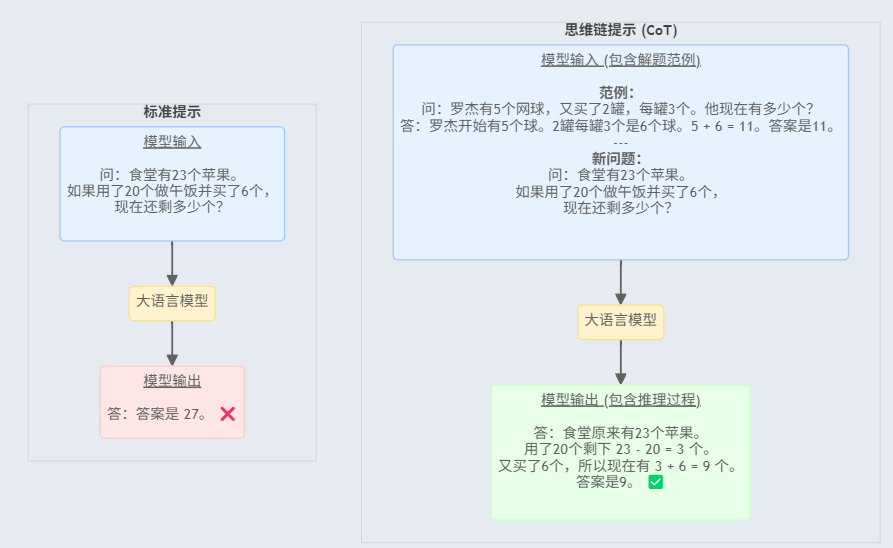

1. 什么是思维链提示?

思维链(Chain-of-Thought)提示是一种旨在激发并增强大型语言模型推理能力的技术。在处理需要多步推理的复杂问题时,如果直接提问,大模型可能会像学生跳过计算步骤一样,直接给出一个错误的答案。

思维链提示的核心思想就是引导模型模仿人类的思考过程,一步步地拆解问题,而不是直接输出最终答案。这通常通过在输入问题中加入”让我们一步一步地思考”之类的提示语来实现。

通过显式地生成一个引导出最终答案的”思维链”(即一系列中间推理步骤),这项技术能够显著提升模型在复杂任务上的准确性和可解释性。因为我们可以清楚地看到它的思考脉络,从而判断其逻辑是否正确。

2. 现有方法的局限与自动化动机

尽管思维链效果显著,但主流的实现方法却各有明显的优缺点,这催生了对自动化方案的迫切需求。

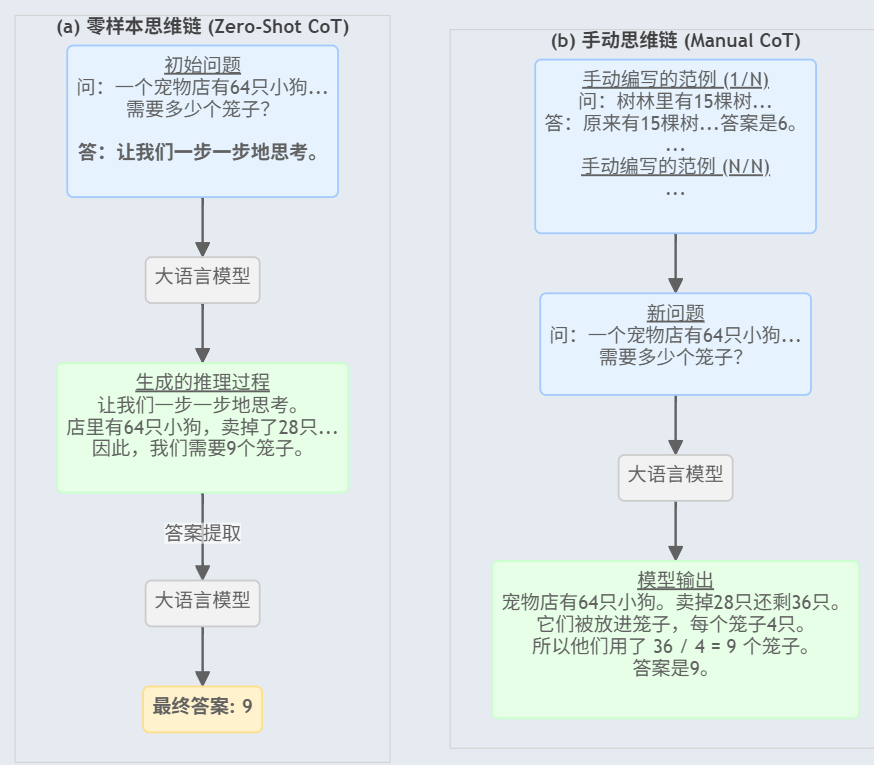

2.1 “零样本思维链”的便利与陷阱

这种方法非常简单,只需在问题后加上一句”让我们一步一步地思考”即可,无需提供任何解题范例。

优点:使用门槛极低,即插即用,非常方便。

缺点:由于缺乏正确范例的引导,模型自己”思考”出的推理步骤常常包含错误或逻辑断裂,导致最终答案并不可靠。这就像让一个学生在没有看过任何例题的情况下直接解决难题,很容易”跑偏”。

2.2 “手动思维链”的可靠与繁琐

这种方法需要由人类专家为模型精心编写多个高质量的”问题 - 推理步骤 - 答案”范例。模型在解决新问题时,会参考这些范例进行思考。

优点:由于有高质量范例作为参考,模型的推理过程更加稳健和准确,效果最好。

缺点:编写这些详尽的范例极其耗时,需要大量的人工努力和领域知识,完全无法规模化。为每个新任务都制作一套高质量范例,成本非常高昂。

2.3 核心矛盾:自动化思维链的诞生

总结一下,零样本思维链方便但不可靠,手动思维链可靠但费力。这正是研究者们提出自动化思维链方法想要解决的核心矛盾。

自动化思维链的核心目标是,利用大模型自身的能力来自动地生成用于引导的推理示例,从而摆脱人工的束缚。这有望结合两种传统方法的优点——既能保证推理的可靠性,又能轻松实现规模化。

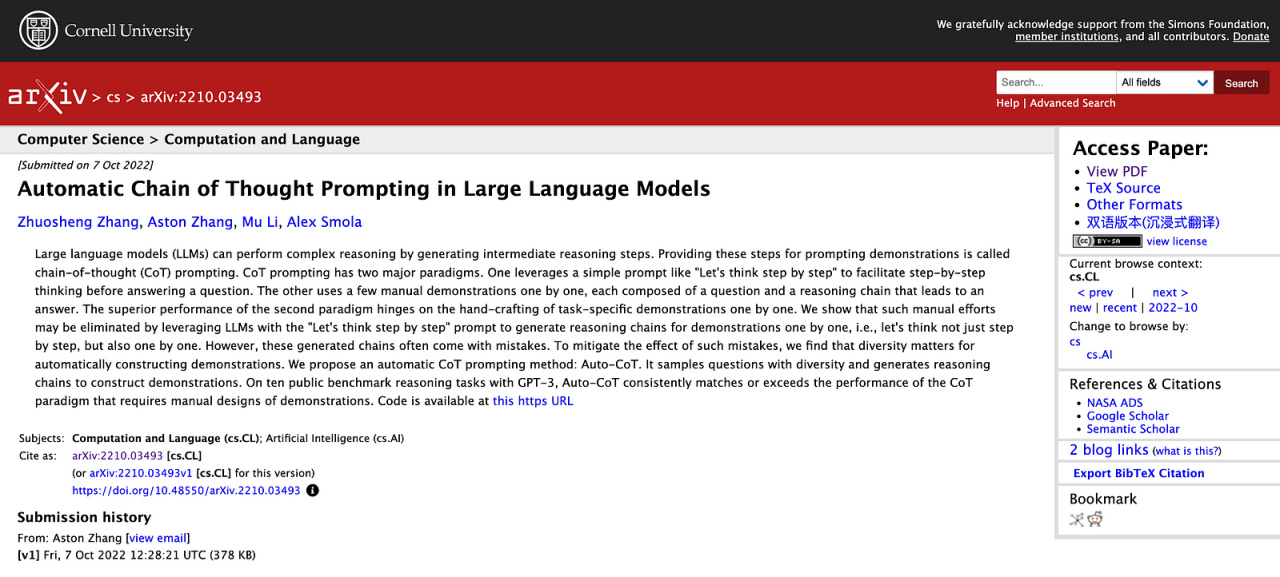

3. 自动化思维链的诞生:解读核心论文

本节我们将来探讨 2022 年发表的经典论文《Automatic Chain of Thought Prompting in Large Language Models》中的细节,正是这篇论文提出了自动化思维链(Auto-CoT)的概念。

3.1 关键洞察:多样性比正确性更重要

为解决现有方法的局限,研究者们提出了一种名为”自动化思维链”的新范式。其核心洞察非常巧妙:

研究者们认识到,由模型自动生成的推理链可能包含错误。但他们没有去验证这些推理链的正确性,而是将重点放在了确保所选演示问题的多样性上。他们发现,只要用于引导的示例问题足够多样,能够覆盖各种类型,即使个别示例的推理过程不完美,模型也能学习到”分步思考”的 général 模式,从而在新问题上做出正确的推理。

3.2 实现方法:问题聚类与示例生成

基于上述洞察,他们设计了两步构建法:

-

问题聚类:首先,利用语义相似度算法,将一个大型问题集中的问题自动划分成若干个簇。这确保了每个簇代表一种特定类型的问题。

-

示例生成:然后,从每个簇中选择一个最具代表性的问题,并使用简单的”零样本思维链”方法(即加上”让我们一步一步地思考”),让大模型为该问题自动生成一条推理链,作为最终的演示示例。

3.3 评估与结论

作者用 GPT-4 在包括算术、常识和符号推理在内的十个基准推理任务上,对自动化思维链进行了评估,并将其与零样本和手动两种方法进行了性能比较。

结果表明,自动化思维链的性能始终与需要人工设计示例的手动方法相当,甚至在某些任务上超越了它。这雄辩地证明了,大模型可以在无需人工干预的情况下,通过自动构建的示例来完成高效的思维链推理,为这项技术的规模化应用铺平了道路。

4. 自动化思维链的工作原理详解

自动化思维链的核心是自动生成演示示例,以取代手动编写。其工作流程清晰地分为以下三步:

4.1 第一步:问题聚类

首先,将用于测试的一组问题(通常来自标准基准数据集)通过嵌入模型转换为向量,再根据向量的相似性进行分组,形成几个簇。

聚类的目的是确保最终选出的演示示例能够覆盖不同类型的问题,避免因示例类型单一而导致模型”偏科”。

4.2 第二步:代表性示例生成

对于每个问题簇,系统会从中挑选出一个最具代表性的问题(例如,最接近该簇几何中心的问题)。

然后,它使用”让我们一步一步地思考”这样的零样本提示,让大模型为这个代表性问题生成一条完整的推理链(包括中间步骤和最终答案)。

这条推理链就构成了该簇的一个自动化演示示例。

4.3 第三步:构建提示并进行推理

当需要评估一个新问题时,系统会将所有自动生成的演示示例(每个簇一个)连同新问题一起,组合成一个完整的提示,并提供给大模型。

大模型会参考这些示例,模仿其分步推理的模式,为新问题生成自己的推理过程,并最终得出答案。

5. 扩展讨论:为什么自动化思维链离不开大模型接口?

将自动化思维链与稳定、高效的大模型应用程序接口(API)结合使用,才能发挥出它真正的威力。

这主要基于以下几点原因:首先,自动化思维链的效果上限,取决于其背后大模型的智能水平。通过调用接口,你可以轻松地将业界顶尖的模型(如 GPT-4 或 Llama 3 系列)集成到你的系统中,从而获得最佳的推理能力。

其次,不同模型的”脾气”和特长各不相同。接口化的服务让你能灵活地测试和切换不同的模型,找到在你的特定任务上表现最好的那一个。同时,你还可以方便地调整温度(temperature)、顶 p 采样(top_p)等参数,精细控制模型输出的随机性和多样性,使其更符合你的业务需求。

最后,可靠的大模型接口服务为你解决了所有底层部署和扩容的烦恼。随着你的业务增长,请求量上升,你无需担心服务器的维护和性能瓶颈,可以专注于应用逻辑本身。同时,大模型技术迭代迅速,一旦有新版本发布,通过接口调用,你几乎可以无缝地享受到最新的技术红利,让你的系统始终保持竞争力。

6. 总结

思维链提示是提升大模型复杂推理能力的关键技术,但传统的手动方法费时费力,限制了其应用。

自动化思维链(Auto-CoT)通过让模型自己生成多样化的推理示例,巧妙地解决了这一难题,在保证效果的同时实现了规模化。

而要想让这项技术真正落地并发挥价值,离不开稳定、强大的大模型接口(LLM API)。接口提供了顶尖的模型能力、灵活的调用方式和无忧的运维保障,是连接前沿算法与实际应用的关键桥梁。

总的来说,自动化思维链这个方向极具前景,它让机器像人一样思考的梦想又向前迈进了一大步。