多模态不只是图文拼贴

市面上号称“理解图像 + 对话”的模型不少,但能真正在产品中接管操作、进行图形编程、面向任务完成交互的,多数仍停留在演示层面。Qwen3-VL-235B-A22B-Thinking,来自通义千问团队,是一款不太“礼貌”的选手:它不只是看图说话,而是真正能“看图干活”。

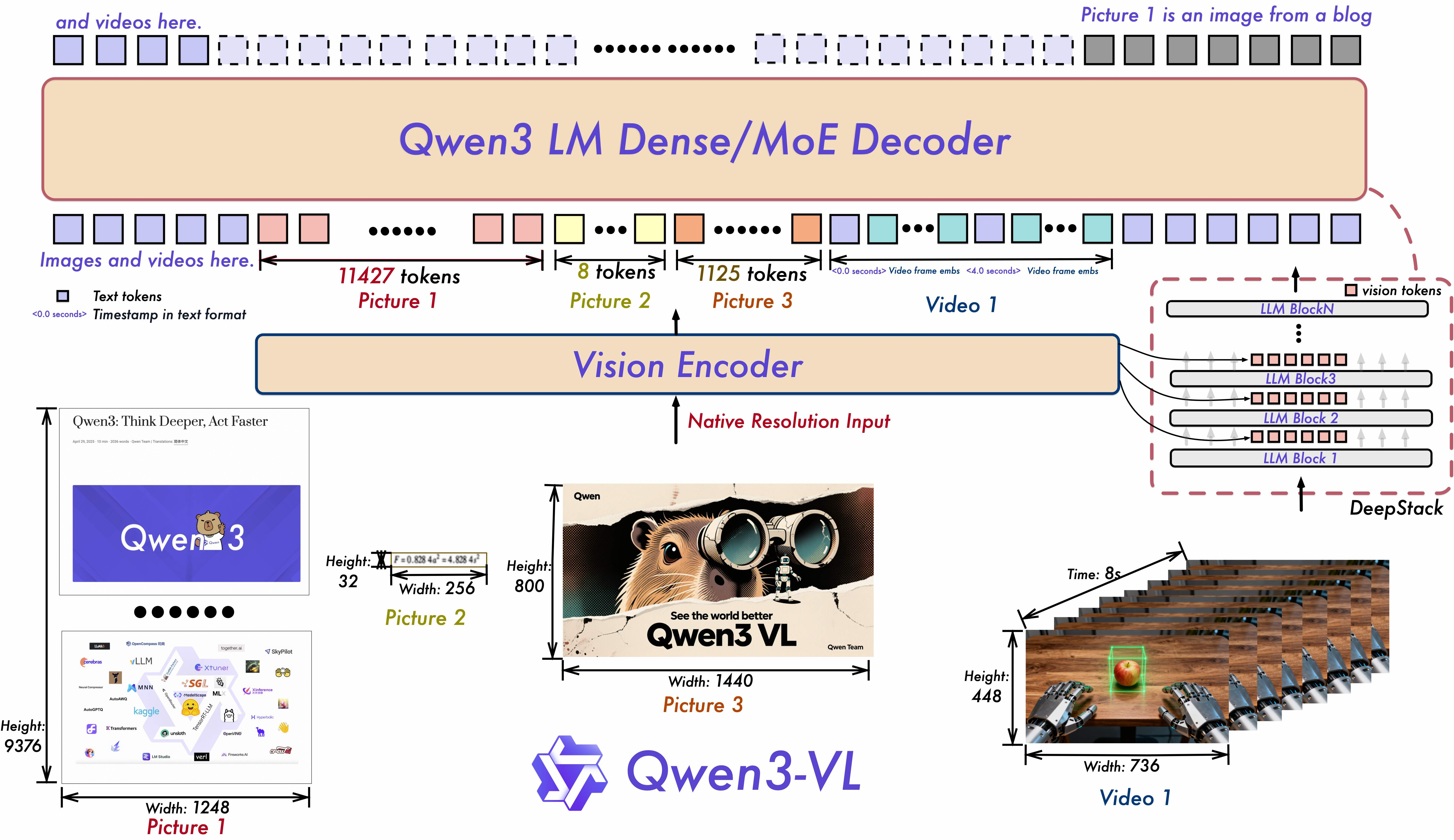

从功能结构来看,Qwen3-VL 有两个关键词值得关注:“深堆栈视觉模型”和“时序感知增强”。这并不是堆数据硬训练、更大更猛,而是结构级别的视觉增强。具体方式是通过 DeepStack 特征融合模块提升图文对齐精度,再辅以 Interleaved-MRoPE 让时间、宽度和高度维度的位置信息形成互补,这种设计令它在长视频分析上甩开一众竞品。

真正用得上的“AI 代理”

过去我们说“Agent”,往往指向文本自动化:自动写脚本、爬网页、调接口。但 Qwen3-VL 的视觉 Agent 能做到界面识别、按钮功能解释、复用历史操作路径来执行自动导航任务。这类能力在移动端 App 自动化测试、企业 GUI 流程集成里有天然价值。产品层可以直接将其作为 UAT(用户验收测试)助手或轻量交互系统的原型驱动器。

既然能识图识流程,它自然也能写代码——而且不止是注释图形生成代码,而是结合语义意图和可视信息,精准生成如 HTML、Draw.io、Canvas 等代码片段。在笔者的一次测试中,上传手绘页面布局草图,Qwen3-VL 几乎完全复原了它对应的 HTML DOM 结构。

再长的上下文也不迷路

支持原生 256K 上下文,还能扩展到 1M,这一点是真的“未来感”的体现。文本模型即便到了 100K,很多仍会在 attention 展开或缓存管理中出锅,而 Qwen3-VL 在设计中采用低功耗的记忆读取策略以及 FlashAttention 2 的支持,在视频处理或超长图文链中仍保持全局一致性。

这使得它能处理整本 STEM 教材、跨章节的因果追踪,甚至做到多模态下的“一页总结”功能。这类能力不再是“漂亮的表演”,而是可以直接用在视觉教程 OCR 编排、跨页检索提示生成这样的应用场景。

模型仓库与部署路径

Qwen3-VL-235B-A22B-Thinking 的权重已可通过以下平台获取:

Hugging Face 模型页:https://huggingface.co/Qwen/Qwen3-VL-235B-A22B-Thinking

其代码已集成入 Hugging Face Transformers 主干,推荐采用源码安装最新版(需注意目前 4.57.0 尚未正式发布)。根据实际用途选择 Dense 或 MoE 架构,并优先开启 FlashAttention 以获得性能和内存表现的双重收益。

小结

Qwen3-VL 并未重新定义多模态模型的参数规模,但却实实在在地扩宽了交互维度。当主流还在追求“理解文本描述图像”的时候,它已经开始理解 GUI、执行点击、生成布局、串起长时序事件流,其在“从感知走向动作”上的尝试,代表了视觉大模型的新方向。